Moin Leute.

eigentlich sollte ich mich gar nicht beschweren.

Ich habe meinen 5900 X undervolted. Sowie meine 4070ti.

die Temperaturen sind SEHR viel besser geworden. Auch beim gaming bemerke ich einen ordentlichen FPS Schub.

und natürlich gesenkten Stromverbrauch.

ABER.

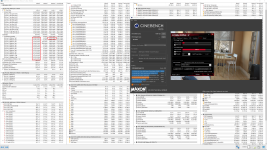

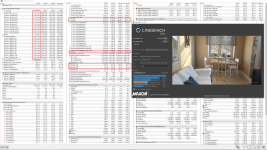

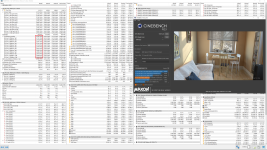

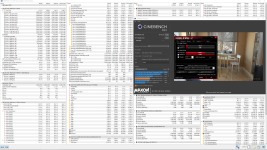

mein cinebench score war VOR dem anpassen bei 12k punkten.

JETZT ist er nur noch bei knapp 2k.

er braucht auch deutlich länger zum rendern.

wie bitte ist es möglich !?

orientiert habe ich mich an diesem video.

und konnte sogar exakt seine werte übernehmen.

Bis 2:45 habe ich alles so übernommen.

Bei Fragen, oder zur Vollständigkeit - werde ich ergänzend antworten.

eigentlich sollte ich mich gar nicht beschweren.

Ich habe meinen 5900 X undervolted. Sowie meine 4070ti.

die Temperaturen sind SEHR viel besser geworden. Auch beim gaming bemerke ich einen ordentlichen FPS Schub.

und natürlich gesenkten Stromverbrauch.

ABER.

mein cinebench score war VOR dem anpassen bei 12k punkten.

JETZT ist er nur noch bei knapp 2k.

er braucht auch deutlich länger zum rendern.

wie bitte ist es möglich !?

orientiert habe ich mich an diesem video.

und konnte sogar exakt seine werte übernehmen.

Bis 2:45 habe ich alles so übernommen.

Bei Fragen, oder zur Vollständigkeit - werde ich ergänzend antworten.