- Mitglied seit

- Jun 1, 2018

- Beiträge

- 10.494

- Bewertungspunkte

- 19.672

- Punkte

- 114

- Alter

- 59

- Standort

- Labor

Kosten- und Verfügbarkeitsfrage. Nicht mal AMD klammert sich da noch dran

War schon von Vorteil bei der Red Devil 5700XT, das der Kuehler uebers PCB ragte und ein Luefter durch pusten konnte.Der Kühler kann bei einem Großteil seiner Länge durchpusten, ohne dass die Abluft von der Platine umgelenkt wird.

Ich weiss nicht mehr ob es hier irgendwo im Forum war oder in einem Video aber ich meine, Igor hatte mal gesagt das pro Stapel HBM auch so 10 Watt an Verlustleistung zusammenkommen. 2 davon und du bist gar nicht mehr so weit weg von den ~30W pro Seite bei Vollbestückung mit GDDR6x. HBM ist ja auch noch direkt am die dran, also kommst du je nachdem was die GPU verbrät, wahrscheinlich auch nicht um eine teure Vaporchamber drumrum. Ich bin mir auch nicht sicher ob über den Interposer dann auch noch großartig Wärme auf das ganze PCB übertragen wird so das eine vernünftige Backplate da noch Wärme raussaugen kann.Mal eine technische Frage, da hier im Forum ja eine Menge Kompetenz unterwegs ist:

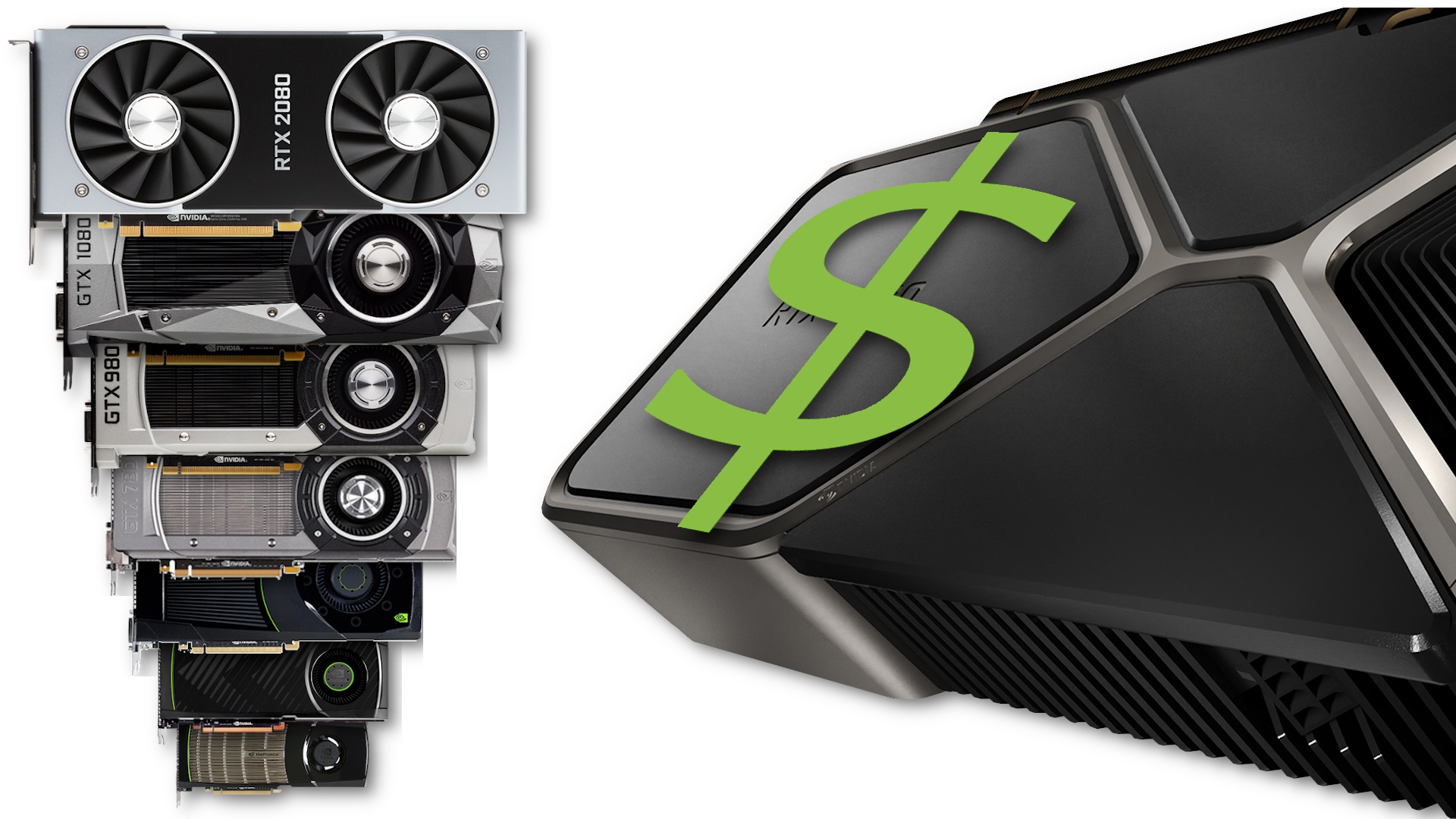

Soweit ich die bisherigen Leaks verstehe ist ein großer Treiber der Kosten und des Stromverbrauchs der GDDR6x Speicher, da die Anbindung ein aufwendiges PCB benötigt und dieses wiederum aufgrund der engeren Anordnung schwerer zu kühlen ist. Wäre unter Berücksichtigung dieses Dominoeffekts nicht doch HBM interessant? Der ist auch schnell, braucht etwas weniger strom so weit ich weiß und das enge Platimenlayout hat man so oder so. Und damit hat man wenigstens schon Erfahrungen aus dem Quadro Bereich. Gibt es dazu Infos?

ich glaube es ist bisher noch ein Gerücht bzw. SpekulatiusWie kommst Du darauf, dass das PCB doppelseitig mit VRAM bestückt ist?

Wo hast Du diesen Quark her? Die 3090 wird nach der 3080 gelauncht und noch keiner hat ein Sample. Keiner. RAM geht auch doppelseitig, ging schon bei Turing. PG132 hat beide Optionen. Ich habe die Blueprints, die ich aber nicht leake. Bin ja nicht verrückt3090 Samples sollen schon bei der Presse/Youtubern sein aber ohne Treiber

und AIB Model sollen bis 500W gehen xD

wäre schon lustig wenn das stimmt