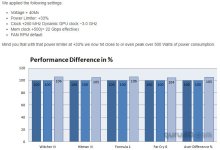

Wenn du nur für Gaming 2.000,- Euro ausgibst, dann verstehe ich die ganze "Spitzen-Technologie"-Argumentationskette nicht. UHD outmaxed in 60FPS (mehr machen die meisten Monitore nicht) geht auch mit der aktuellen Gen. DLSS 3.0 schön und gut - das muss ja auch wer implementieren. Und RT läuft auch - bisher mehr schlecht als recht - auf anderen Karten (auch im grünen Haus).

Da fängt doch schon der Irrtum an. Die meisten UHD Monitore mit 34 Zoll mit

3.440 x 1.440 Pixel gehen locker bis 144 Hertz. Selbst im unteren Preisbereich.

Ich denke da eher an den Content-Producer oder Produktivleistungen, für die macht sich das Investment im Wortsinn bezahlt.

Bestimmt.

Ansonsten sehe ich das wie

@Gregor Kacknoob Hier den Großkapitalisten zu geben und das auf die dickste Gaming-Karte ever runterzubrechen und alle unter Generalverdacht zu stellen, die Cost per Frame in die Rechnung mit aufnehmen – erklär mir bitte mal wo dein Problem liegt.

Die Ausgabe von 2.000 Euro, wobei es nach Verkauf der 3090 eher 1.000 sind macht einen nicht zum Großkapitalisten. das ist doch wirklich lächerlich. Ich habe mir nur erlaubt darauf hinzuweisen, das der Cost per Frame bei der 4090 wahrscheinlich bei der 4090 deutlich günstiger ist, als bei der 4080er Serie. Das kannst du selber nachrechnen. Und wenn was stimmt, dann doch "dickste Gaming-Karte ever".

Warum glaubst du denn wird sie in der ganzen Welt in Gamingszenarien getestet. Weil es

keine Gamingkarte ist? Merkst du eigentlich nicht, wie absurd diese Argumentation ist.

Ja, gibt ein paar Fanboys, die allesamt benannt wurden. Aber wenn hier Foristen nicht nur "Hurra!" schreien, dann ist das mit Blick auf Preisgestaltung und den Abstand zu Nr. 2 und 3 im Portfolio mehr als gerechtfertigt. Du schreibst es ja selbst.

Wer schreit den hier Hurra? Und bei der Preisgestaltung sind wir doch alle eine Meinung. Was ist denn gerade los mit dir?

Zur Karte selbst: Die ist Top-Notch und richtig fein. Allein, ich habe kein Anwendungsszenario, dass die Anschaffung rechtfertigen würde.

Von dir hat doch überhaupt keiner gesprochen. Wenn du kein Anwendungsszenario ist doch alles Presto. Was regst du dich so auf?

Und ich behaupte, dass das vielen so geht, die in der Lage sind, rational zu denken.

Das ist genau mein Humor. Alle die in der Lage sind, rational zu denken, sehen das wie du? Ernsthaft? Bemerkenswerte Vorstellung.

Das vertiefe ich jetzt besser mal nicht.

PS. Vielleicht solltest du NVDIA anschreiben, das sie den Satz auf Ihrer Homepage bezüglich der 4090 : " Für Gamer und Ersteller" entspechend korrigieren. Offenkundig ist Ihnen ja deiner Meinung nach hier ein Fehler unterlaufen.