So, ich teste die RTX 4090 ja nun genauso lange wie Igor. Ich kann nur sagen, das Ding is wirklich irre brutal... So einen Leistungsprung hatte ich nicht auf dem Schirm und musste echt 3x Testen um zu glauben,, was ich da gesehen habe.

Morgen kommt mein Artikel 22 Seiten lang (davon aber um die 8 Seiten nur Videos verlinkt) damit ihr euch DLSS, FSR und XeSS anschauen könnt. Auch das war nur ein kurzer Blick und nur 25 % vom meinen Videomaterial. In UHD sind 5 Sek. Videos gleich mal >30 MB und das mal 3 und mal x die ganzen Settings... könnt euch vorstellen, wie Igor reagiert hat, als ich ihm mein ganzes Material habe schicken wollen. Da is ihm fast das Herz stehen geblieben.

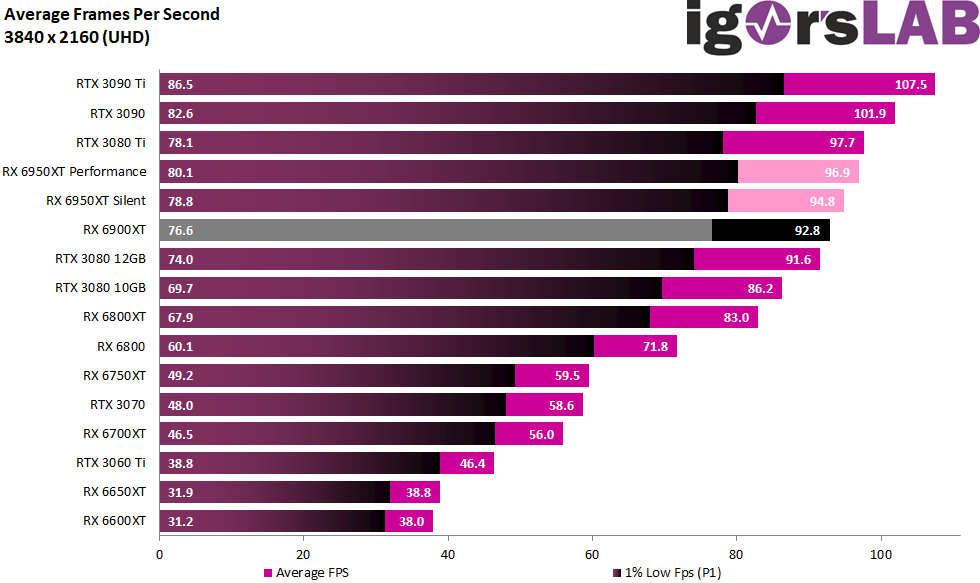

Es gibt 3 Spiele für den Anfang: CoD Black Ops Cold War, SOTTR Lara Croft und Cyberpunk 2077. Holy Shit geht die 4090 ab. Ich brauche einen 240 besser noch 360 Hz UHD Monitor... LOL

Mich würde interessieren, was wohl mit Ampere gewesen wäre, härte man da schon TSMC 7n genommen. Egal...

Ich empfehle morgen einen großen Bildschirm und etwas Zeit mitzubringen