DigitalBlizzard

Urgestein

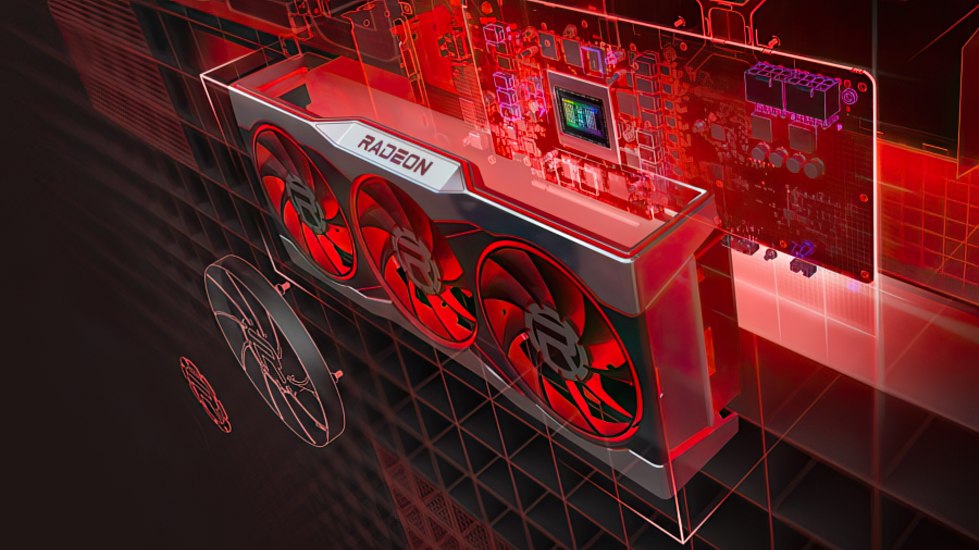

Über die 3070 OC und 3080ti habe ich mich nur grün geärgert.Ne 30X0er Karte hätte ich mir auch nie gekauft. Seit der 5X00er Gen sind die AMDs eigentlich sehr empfehlenswerte Produkte. Darüber besteht aber - glaube ich - Konsens.