Messaufbau allgemein

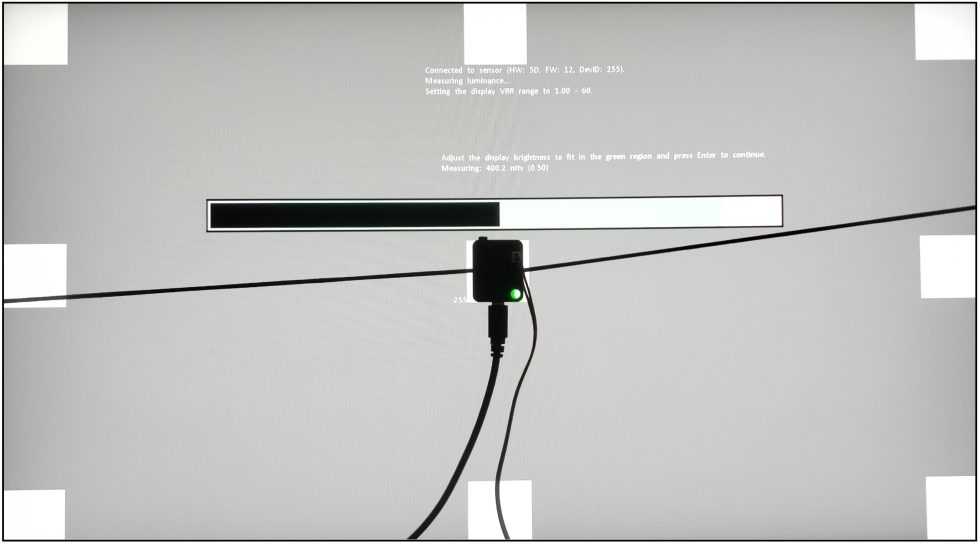

Viel gibt es im Grunde nicht zu sagen. Um die Response Times zu messen, nutze ich NVIDIA LDAT. Dieses wird mittig auf dem Display platziert. So, wie ich mit dem SpyderX z.B. die Farbtreue messe.

Vorher lasse ich den Monitor für eine Stunde bei 200 Nits aufwärmen. Das Panel sollte, wie schon beim Kalibrieren, erstmal warm werden. Dann vermeidet man unterschiedliche Messwerte. Dazu sieht mein aktueller Testaufbau wie folgt aus:

| CPU | Intel Core i9-12900K |

| Mainboard | MSI MPG Z690 Carbon WiFi |

| RAM | 2x 16 GB Corsair Dominator 6000 MHz CL 30-36-36-76 |

| SSD 1 | Samsung 980 Pro 500 GB (System) |

| SSD 2 | MSI M480 2 TB (Spiele) |

| SSD 3 | HP EX950 2 TB (Spiele) |

| SSD 4 | HP SDD S750 1 TB S-ATA (Backup) |

| CPU Kühler | Alphacool Eisbaer Aurora 360 |

| Netzteil | Seasonic Prime Platinum 1300 Watt |

| GPUs |

NVIDIA GeForce RTX 4090 FE (Driver 560.70) MSI AMD Radeon RX 6700 XT Gaming X (Driver 24.7.1) |

| Sound | SoundblasterX AE-5 Plus |

| Tastatur | Sharkoon Purewriter RGB (Red Taster) via USB @1000 Hz Polling Rate |

| Maus | Sharkoon Light² 200 @1000 Hz Polling Rate |

| Monitor |

Titan Army P2510S (IPS-Panel: 2560 x 1440p @ 240 Hz) |

| Test-Tools / Software |

Tools Software |

Sollte sich hier was ändern, dann werde ich das natürlich aktualisieren. Fakt ist, dass die PC-Hardware im Grunde keine Rolle spielt. Ich habe drei verschiedene Rechner an den Monitor angeschlossen, die Ergebnisse waren immer die gleichen. Der Monitor selbst sollte NVIDIA G-Sync kompatibel sein. Ist aber für die GtG Messungen kein muss! Die Response Times messe ich grundsätzlich nach dem Kalibrieren. Das schafft gleiche Bedingungen für alle Monitore.

Messmethode (GtG)

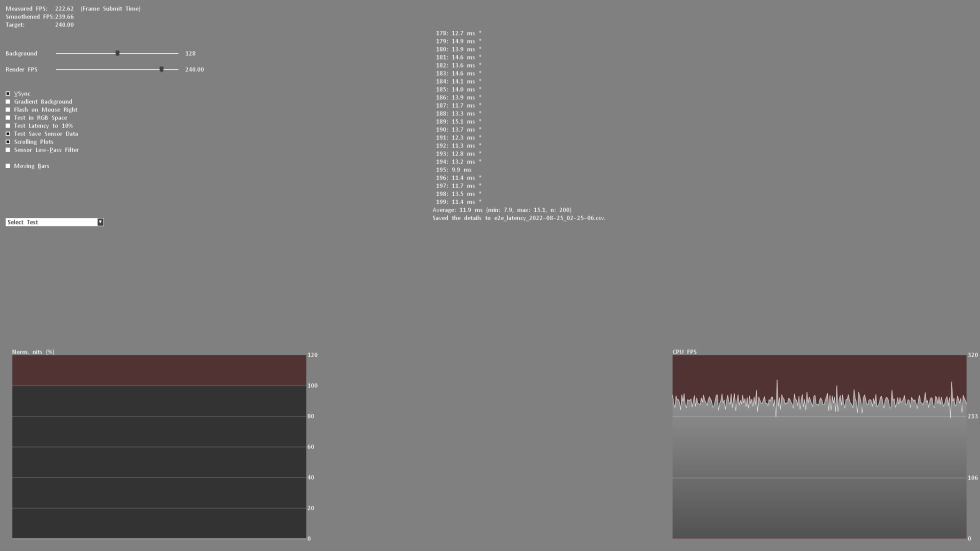

Bei der Grau zu Grau (GtG) Messung werden unterschiedliche Graustufen gemessen. Aber auch von Schwarz = 0 bis 255 = Weiß. Das ergibt dann 36 Response Times im Rise-Up (Schwarz nach Weiß) und 36 im Rise-Down (Weiß nach Schwarz) – macht in Summe 72 Messungen. Hierbei misst LDAT die Zeit in ms, die von der Startfarbe bis zur Zielfarbe benötigt wird.

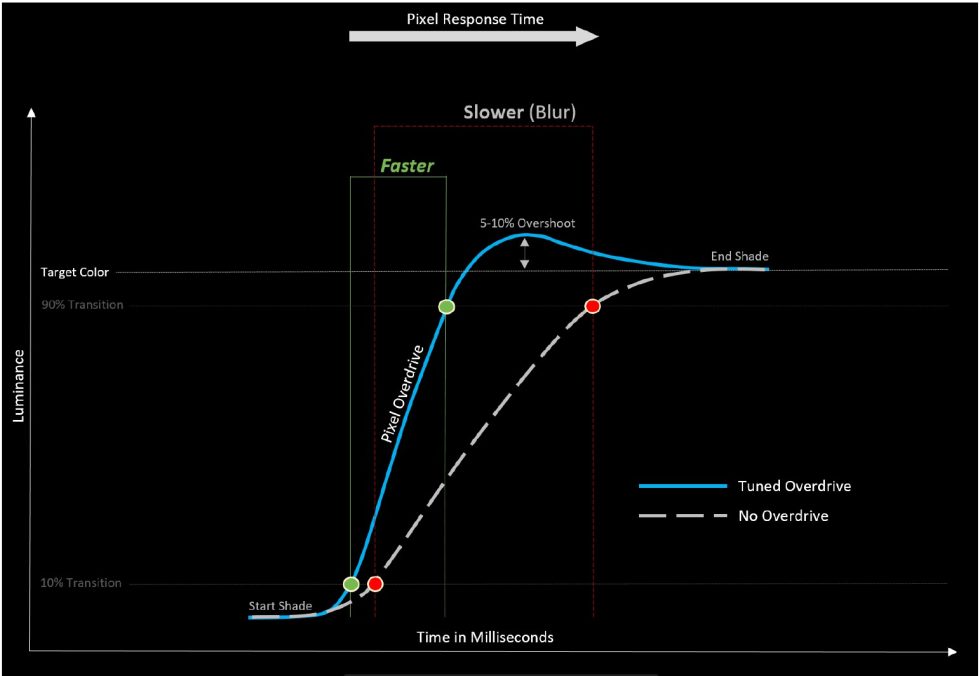

Der aktuell international gültige Standard für die Response Time, ist die 80 % Transition. Bedeutet: Um Messungenauigkeiten in Bezug auf Signalrauschen zu vermeiden, misst auch LDAT erst nach 10 % der Start-Transition-Kurve und 10 % vor dem eigentlichen Ende, wird die Response-Time ausgegeben. Der Overshoot wird dabei gesondert betrachtet. Siehe auch Bild oben.

Des Weiteren ist es mir aktuell technisch nicht möglich, UFO-Aufnahmen zu machen. Dazu fehlt mir einfach das nötige Equipment. Eine einstellbare Highspeed-Kamera (0 bis 1000 FPS) habe ich leider nicht.

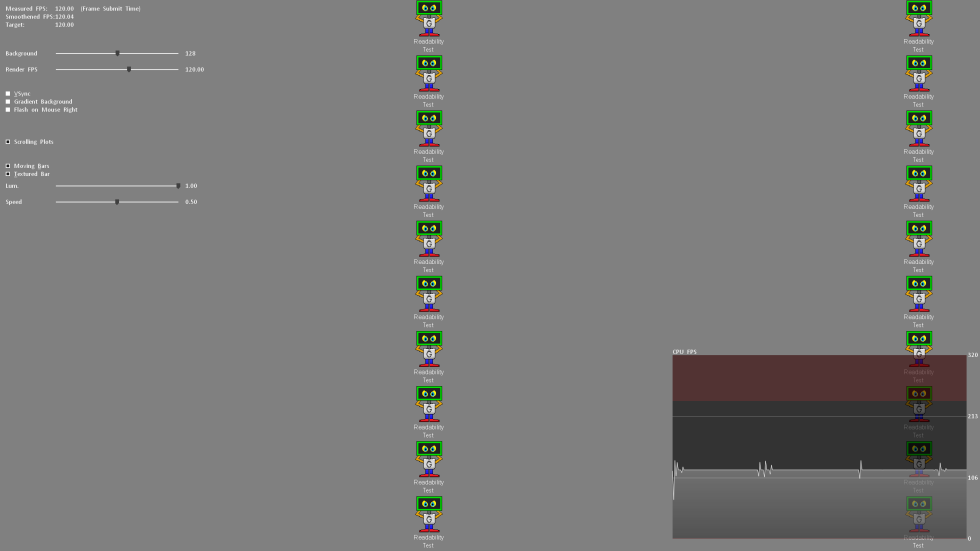

Dennoch schau ich mir die Motion-Clarity zum einen mit UFO (klick hier) und zum anderen mit der NVIDIA LDAT Software an. (siehe Bild oben)

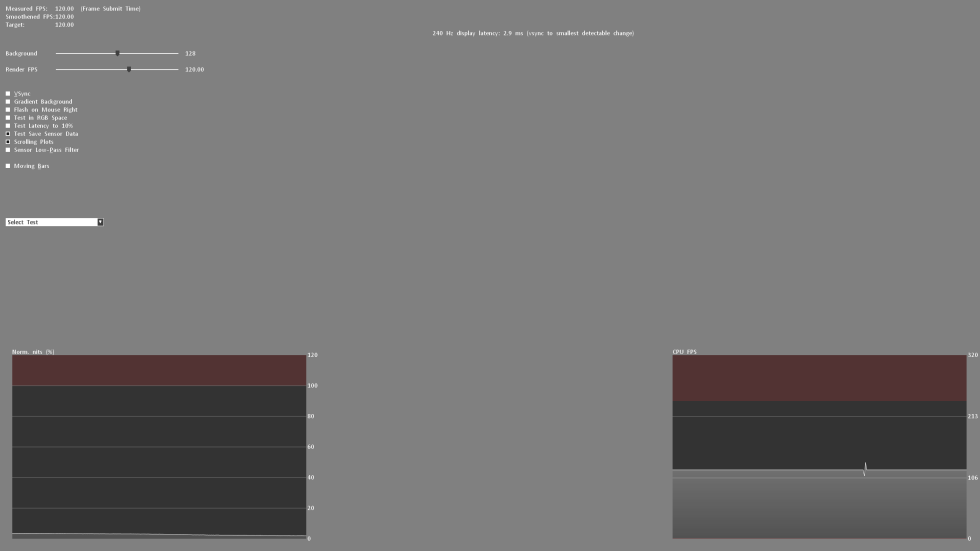

Display Lag, Monitor Input-Lag und E2E Latenz

Der Display-Lag ist die Summe aus Processing-Lag und dem halben Scan-Out (der Bildaufbau bis Mitte Bildschirm = Refesh-Lag). Gemessen via LDAT, hierfür und ich betone – nur für den Display-Lag – ist eine G-Sync Kompatibilität zwingend erforderlich. Das bedeutet quasi FreeSync via DisplayPort. Im NVIDIA-Treiber muss G-Sync aktiviert werden.

Für den eigentlichen Input-Lag addiere ich die durchschnittliche Pixel-Reaktionszeit (spielbares Overdrive) hinzu. Beispiel: 3.6 ms Display-Lag + 2.6 ms Response Time = 6.2 ms Input-Lag

Abschließend messe ich noch die E2E Latenz. Mit anderen Worten: Vom Mausklick bis zur halben Pixel-Response-Time. Ja, hier wird nur die halbe Transition gemessen.

Achtung:

Alle Latenz-Messungen werden bei der maximalen Bildwiederholrate und gleicher FPS durchgeführt. Bsp.: 240 Hz mit 240 FPS

Messen der Color-Performance

Wie ich die Color-Performance messe, habe ich euch bereits im Grundlagenartikel bzgl. Calman Ultimate von Portrait Displays vorgestellt.

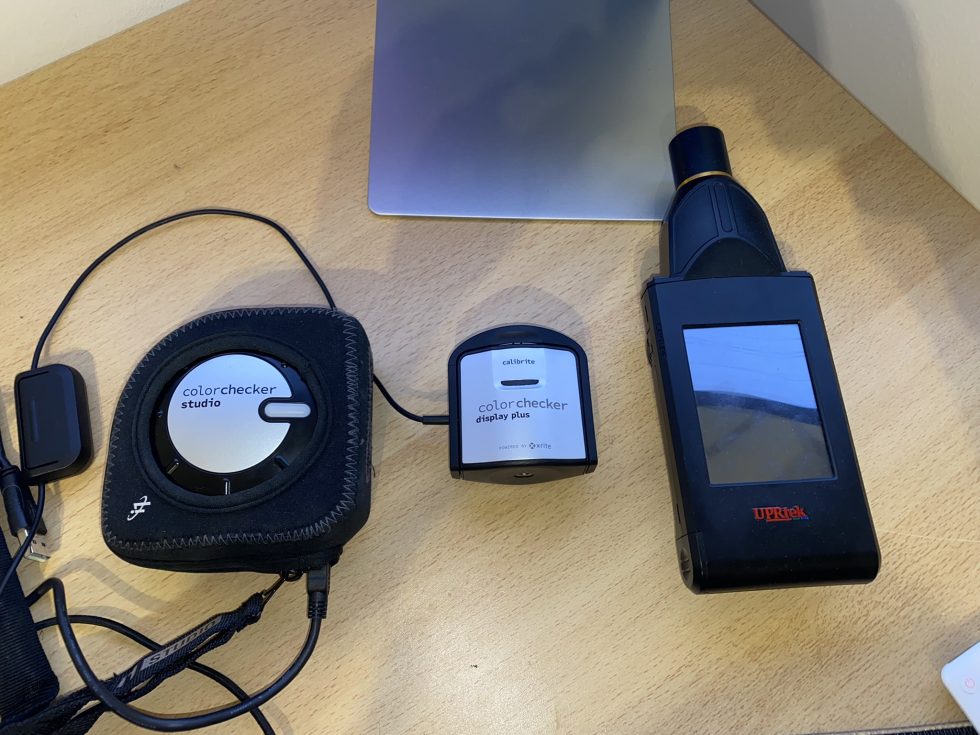

Um euch das bestmögliche in Bezug auf die Farbgenauigkeitsmessungen bieten zu können, nutze ich grundsätzlich das UPRtek MK550T Spectralradiometer.

MK550T_Handheld_Spectroradiometer_10_Specification_EN

Damit wird zum einen der jeweilige Monitor in Verbindung mit Calman Ultimate “profiliert”, sodass ich auch mit dem Calibrite ColorChecker Display Plus Colorimeter genau messen kann. Zum anderen wird jede Kalibrierung mit dem UPRtek MK550T validiert. Des Weiteren führe ich diverse Messungen auch mit der UPRtek uSpectrum Software durch – so z.B. die Spektralanalyse eines jeden Displays in Bezug auf den Balu-Licht-Anteil – Thema Eye-Safe.

Hier nochmal zum Nachlesen:

Für alle Messungen sowie Kalibrierungen habe ich die Farbkalibrierungssoftware Calman Ultimate von Portrait Displays verwendet. Mit meinen Messungen kann ich euch die Gewissheit bieten, ob ein Monitor die Angaben des Herstellers einhält – oder auch nicht.

Hinweis

Wenn ihr euch andere Tests zu Monitoren bei anderen Testern anschaut, dann kann es hier zu Differenzen – insbesondre – bei den Response-Times kommen. Ihr müsst also immer prüfen, wie andere Kollegen sowas messen. Das bedeutet nicht, dass meine oder andere Messungen falsch sind. Die Unterschiede entstehen, aufgrund verschiedener Test-Methodiken bzw. auch unterschiedlicher Hardware. Entscheidend ist, dass man alle Monitore mit der gleichen Messsystematik / Methodik testet. Dann sind die Werte auch gegeneinander vergleichbar. Bitte vergleicht nicht meine Messsystematik eins zu eins mit anderen.

Alle Messungen (Latenzen, Response Times, Color-Performance usw.) werden 3-Mal wiederholt und müssen meiner definierten Genauigkeit unterliegen.

Messwiederholgenauigkeiten:

| Average Response Time | +/- 0,5 ms |

| Average Latency | +/- 1 ms |

| Average delta E 2000 | +/- 0,5 |

| Brightness | +/- 10 Nits |

Das beste Ergebnis wird veröffentlicht. Somit ist die Plausibilität und Fairness am Ende auch gewährleistet! Weiter geht es auf der nächsten Seite.

- 1 - Introduction, Features and Specs

- 2 - Workmanship and Details

- 3 - How we measure: Equipment and Methods

- 4 - Pixel Response Times

- 5 - Display Latencies

- 6 - Color-Performance @ Default Settings

- 7 - Direct Comparison and Power Consumption

- 8 - Color-Performance calibrated

- 9 - HDR-Performance

- 10 - Summary and Conclusion

Kommentieren