Die Computex naht (oder Launch-Season, wie wir es mittlerweile titulieren) und Nvidia lässt den ersten großen Paukenschlag mit einer Implementierung seiner Pascal-Architektur für Gamer los. Die GP104-GPU treibt die neuen GeForce GTX-Karten 1070 und 1080 an. Wir schauen uns heute die GeForce GTX 1080 an, aber die GTX 1070 sollte Anfang Juni auf den Markt kommen – und ihr wird wiederum zweifelsfrei bis Ende 2016 ein breiten Portfolio Pascal-basierter Grafikarten folgen.

Pascal verspricht mehr Leistung sowie bessere Effizienz, bringt mehr Ressourcen in seiner Grafik-Pipeline mit, ist dichter auf einem kleineren Die gepackt, verfügt über schnelleren Speicher an einem überarbeiteten Controller und sollte das neue Heilsmittel für VR- und 4K-Gaming sein. Aber wie bei jedem Launch einer neuen Architektur gibt es noch viel mehr zu sehen – unter der Haube. Wie immer fühlen wir den Versprechen der Hersteller genau auf den Zahn und testen, was das Zeug hält. Viel Spaß beim Lesen!

Kann die GeForce GTX 1080 das High-End-Segement durcheinanderwirbeln?

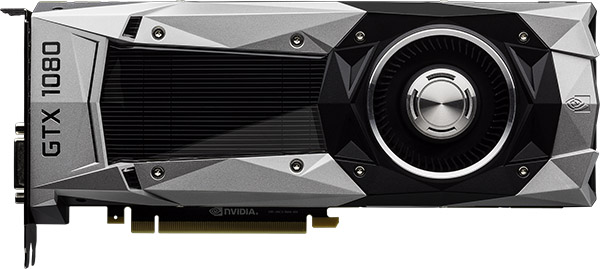

Nvidias GeForce GTX 1080 ist die schnellere von zwei Desktop-Grafikkarten, die diesen Monat vorgestellt wurden. Beide nutzen die GP104-GPU, die übrigens schon Nvidias zweite GPU ist, die auf der Pascal-Architektur basiert. Nvidias CEO Jen-Hsun Huang köderte Enthusiasten während seiner Präsentation zudem mit der Behauptung, dass die GeForce GTX 1080 schneller sein soll als zwei GTX 980 im SLI-Verbund.

Man sagte uns, dass die GTX 1080 mehr Performance bietet und dabei weniger Leistung aufnimmt als die 900er Serie. Sie soll außerdem die Performance des ehemaligen Flaggschiffs GeForce GTX Titan X nahezu verdoppeln und dabei dreimal so effizient sein – zumindest bezogen auf bestimmte VR-Workloads. Trotzdem: Wenn sich diese Aussagen auch nur ansatzweise bewahrheiten, bedeutet das einen neuen Höhepunkt in Sachen High-End-PC-Gaming, auch wenn die GeForce GTX 1080 non-Ti mit Sicherheit nur das vorübergehende Flaggschiff sein dürfte.

VR-Gaming steht gerade erst am Anfang – und heftige Anforderungen an die Grafik-Hardware stellen eine nicht zu unterschätzende Barriere für den Einstieg dar. Dazu kommt noch, dass die meisten aktuell verfügbaren Games noch nicht auf die Nutzung von Multi-GPU-Rendering programmiert sind. Das bedeutet, dass man generell auf die schnellste Single-GPU-Grafikkarte limitiert ist, die man finden kann. Wenn eine GTX 1080 wirklich zwei 980er übertrumpfen kann, sollte sie kein Problem mit aktuellen VR-Titeln haben und den Bedarf an Multi-GPU-Setups egalisieren.

Das 4K-Ökosystem entwickelt sich ebenfalls langsam, aber stetig. Zum Ende des Jahres werden neue Display-Schnittstellen mit mehr Bandbreite erwartet, dank denen 4K-Monitore mit 120-Hz-Panels und dynamischen Bildwiederholraten möglich werden. AMD und Nvidia bewarben zwar auch schon die High-End-Modelle der Vorgängergenerationen mit der Fähigkeit zum 4K-Gaming, aber wenn man flüssig spielbare Performance haben wollte, musste man qualitative Kompromisse eingehen. Nvidias GeForce GTX 1080 könnte die erste Grafikkarte sein, mit der man wirklich sauber bei 3840 x 2160 Pixeln spielen kann – und zwar mit allen Detaileinstellungen auf Maximum.

Und wie sieht es mit Multi-Monitor-Setups aus? Viele Gamer geben sich mit drei Full-HD-Monitoren (1920 x 1080 Pixel) zufrieden – oft aber nur, um ihre Hardware zu schonen. Denn für eine effektive Auflösung von 7860 x 1440 – bei drei WQHD-Displays – wollen sekündlich (!) eine halbe Milliarde Pixel verarbeitet werden. Und es gibt sogar Enthusiasten, die den WQHD-Zwischenschritt am liebsten überspringen und gleich zu einem Array aus drei 4K-Displays mit einer effektiven Auflösung von 11.520 x 2160 Pixeln wechseln würden.

Aber gut – das dürfte sogar für Nvidias neuestes Gaming-Flaggschiff ein bisschen zu übertrieben und exotisch sein. Aber Nvidia hat Technologien in seine GP104-GPU eingebettet, die bessere Performance mit Workloads versprechen, die am dringendsten mehr Power brauchen – 4K und Surround. Aber bevor wir uns mit diesen Extras beschäftigen schauen wir uns erst einmal die GP104 und die ihr zugrunde liegende Pascal-Architektur etwas genauer an.

Was steckt in der GP104?

AMD und Nvidia haben sich seit Anfang 2012 auf 28-nm-Prozesstechnik verlassen. Anfänglich konnten die beiden Hersteller mit Karten wie der Radeon HD 7970 und der GeForce GTX 680 große Sprünge machen. Über die nächsten vier Jahre hinweg mussten sie auf der Suche nach dem High-Performance-Gral allerdings immer kreativer werden. Was die Radeon R9 Fury X und die GeForce GTX 980 Ti schaffen, ist angesichts ihrer Komplexität einfach nur erstaunlich. GK104 – Nvidias Erstversuch in Sachen 28-nm-Prozesstechnik – war ein 3,5-Mrd.-Transistoren-Chip. GM 200, das Herz der GeForce GTX 980 Ti und der GeForce GTX Titan X, hatte acht Milliarden Transistoren an Bord.

Mit dem Wechsel hin zu TSMCs 16-nm-FinFET-Plus-Prozesstechnik (16FF+) können Nvidias Ingenieure erst mal durchschnaufen: Laut dem Chip-Fertiger ist 16FF+ bis zu 65 Prozent schneller und ermöglicht die doppelte Dichte oder eine um 70 Prozent niedrigere Leistungsaufnahme als 28HPM – und Nvidia nutzt garantiert eine optimierte Kombination dieser Attribute für die Fertigung seiner GPUs. TSMC behauptet außerdem, dass es den Metal-Backend-Prozess seiner existierenden 20-nm-Prozesstechnik nutzt – nur halt mit FinFETs statt planaren Transistoren. Obwohl dieser Schritt laut TSMC den Ertrag erhöhen und die Prozessreife verbessern soll, ist es schon ziemlich bezeichnend, dass es keine High-Performance-20-nm-Prozesstechnik gab (wie gesagt: Grafikkartenhersteller setzen seit vier Jahren auf 28 nm).

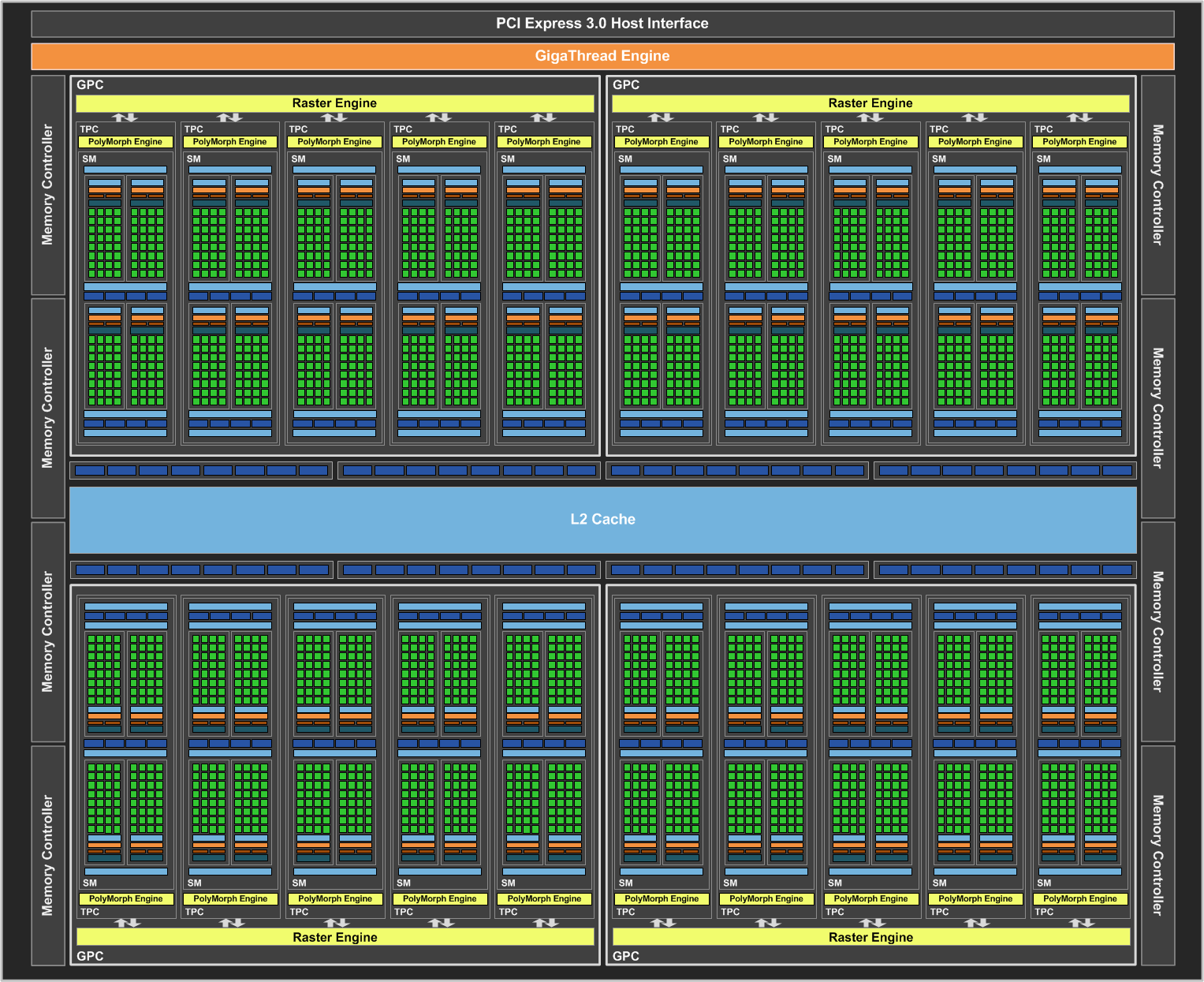

Folgerichtig ist der geistige Nachfolger der GM204-GPU aus 7,2 Milliarden Transistoren zusammengesetzt, die sich auf einer Fläche von 314 mm² zusammenballen – man vergleiche das mit den 5,2 Milliarden Transistoren der GM204 auf einem 398-mm²-Die. In der höchsten Ausbaustufe beinhaltet eine GP204 vier Graphics Processing Cluster (GPC). Jeder GPC beinhaltet fünf Thread/Texture Processing Clusters (TPC) und die Raster Engine. Ein TPC wiederum kombiniert einen Streaming Multiprocessor (SM) und eine PolyMorph-Engine.

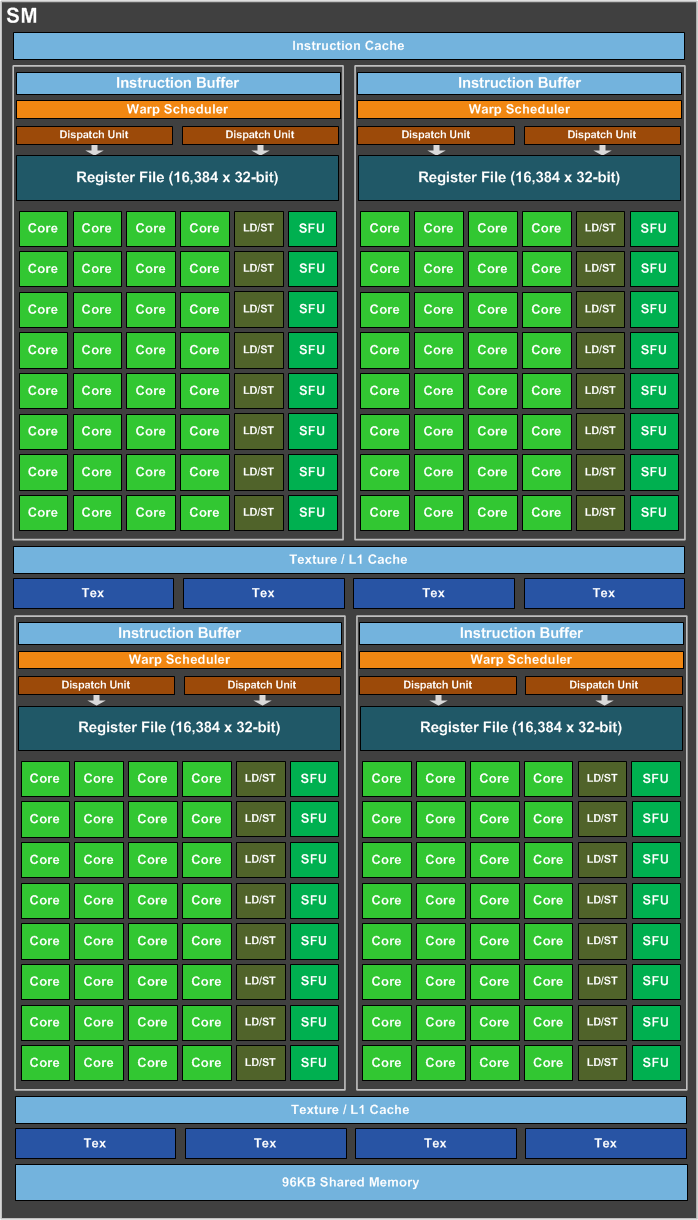

Der SM besteht aus 128 CUDA-Kernen (SinglePrecision), einem 256-KByte-Register, 96 KByte Shared Memory, 48 KByte L1/Textur-Cache und acht Textur-Einheiten. Die PolyMorph-Engine der vierten Generation enthält einen neuen Logikblock, der am Ende der Geometrie-Pipeline und vor der Raster-Einheit sitzt, die für Nvidias ‘Simultaneous Multi-Projection’-Feature zuständig ist (mehr dazu auf den Folgeseiten). Wenn man dies über alle 20 SMs zusammenrechnet, kommt man auf 2560 CUDA-Kerne und 160 Textur-Einheiten.

Das Backend der GPU bietet acht 32-Bit-Speicher-Controller (was somit einen aggregierten Speicherbus von 256 Bit Breite ergibt) sowie je acht ROPs und 256 KByte L2-Cache je Controller, was aufsummiert 64 ROPs und zwei Megabyte L2-Cache für die ganze GPU ergibt. Obwohl Nvidias Blockschaltbilder der GM204 vier 64-Bit-Controller und ebenso viele 16-ROP-Partitionen zeigte, waren diese gruppiert und funktionell äquivalent. Wo wir schon dabei sind: Einige der strukturellen Spezifikationen der GP104-GPU erinnern an Teile der GM204-GPU – und in der Tat basiert die neue GPU auf Baublöcken des Vorgängers. Das ist keine schlechte Sache, denn bei der Maxwell-Architektur legte Nvidia großen Wert auf eine Steigerung der Effizienz, ohne dafür die Vorteile der Kepler-Architektur opfern zu müssen – und das Gleiche gilt auch hier.

Das Hinzufügen von vier SMs mag nicht nach viel aussehen, wenn man eine dramatisch höhere Performance erzielen will. Aber GP104 hat ein paar Asse im Ärmel. Eines davon ist eine deutlich höhere Taktfrequenz: Nvidias GPU-Basistakt liegt bei 1607 MHz. Zum Vergleich: GM204 war mit 1126 MHz spezifiziert. Der Boost-Takt der GP104 liegt bei 1733 MHz – und wir konnten unser Test-Sample mittels einer Beta-Version von EVGAs PrecisionX-Utility sogar auf knapp über 2100 MHz Boost übertakten.

Was es braucht, um so viel Luft nach oben zu bekommen? Laut Jonah Alben, Nvidias Senior Vice President of GPU Engineering, wusste sein Team, dass TSMCs 16FF+ das Design des Prozessors verändern würde. Also habe man sich darauf konzentriert, die Timings des Chips zu optimieren, um Pfade freizumachen, die schnellere Taktfrequenzen verhindern würden. Das Ergebnis: Die Single-Precision-Compute-Performance der GP104 erreicht einen Wert von 8228 GFLOPs (wenn man beim Basis-Takt bleibt), während die GeForce GTX 980 maximal 4612 GFLOPs schafft. Und die Textur-Füllrate springt von den 155,6 GT/s der GTX 980 (bei Boost-Frequenz) auf satte 277,3 GT/s.

| GPU | GeForce GTX 1080 (GP104) | GeForce GTX 980 (GM204) |

|---|---|---|

| SMs | 20 | 16 |

| CUDA Cores | 2650 | 2048 |

| Base Clock | 1607MHz | 1126MHz |

| GPU Boost Clock | 1733MHz | 1216MHz |

| GFLOPs (Base Clock) | 8228 | 4612 |

| Texture Units | 160 | 128 |

| Texel Fill Rate | 277.3 GT/s | 155.6 GT/s |

| Memory Data Rate | 10 Gb/s | 7 Gb/s |

| Memory Bandwidth | 320 GB/s | 224 GB/s |

| ROPs | 64 | 64 |

| L2 Cache | 2MB | 2MB |

| TDP | 180W | 165W |

| Transistors | 7.2 billion | 5.2 billion |

| Die Size | 314mm² | 398mm² |

| Process Node | 16nm | 28nm |

Und auch wenn wir immer noch über ein Backend mit 64 ROPs und einem 256 Bit breiten Speicherinterface sprechen: Nvidia verbaut GDDR5X-Speicher, um die verfügbare Bandbreite aufzupeppen. Nvidia hat sich alle Mühe gegeben, diesen Schritt so positiv wie möglich darzustellen – obwohl etliche AMD-Karten HBM verbauen und Nvidias eigene Tesla P100 sogar schon HBM2 als Speicher mitbringt. Aber wie es aussieht, gibt es momentan nicht genug HBM2-Speicher und Nvidia ist nicht willens, sich mit den Limitierungen von HBM herumzuschlagen (auf den Punkt gebracht: vier 1-GByte-Stapel oder die Probleme, die mit acht 1-GByte-Stapeln einhergehen).

Somit wurde folgerichtig GDDR5X-Speicher verbaut, der ebenfalls nicht gerade breit verfügbar sein dürfte, weil die Massenproduktion gerade erst gestartet wurde. Das erklärt dann auch, dass die GTX 1070 „normalen“ GDDR5-Speicher nutzt. Allerdings sollte man das Ganze nicht kleinreden: Mit GDDR5 waren auf der GeForce GTX 980 Datenraten von sieben GBit/s möglich. An einem 256-Bit-Bus resultierte das in einem Durchsatz von bis zu 224 GByte/s. Bei GDDR5X geht das Ganze bei zehn GBit/s los, was eine Bandbreite von 320 Gbyte/s bedeutet – eine 43-prozentige Steigerung. Nvidia zufolge soll die die Energieaufnahme wegen eines überarbeiteten I/O-Schaltkreises zudem nicht gestiegen sein. Außerdem schafft Nvidia damit auch recht elegant noch einen zusätzlichen Abstand zur günstigeren GeForce GTX 1070.

Die Maxwell-Architektur nutzte die zur Verfügung stehende Bandbreite durch optimierte Caches und Kompressionsalgorithmen effektiver – und Pascal stößt durch die Implementierung neuer Lossless-Techniken, die an verschiedenen Stellen des Speichersubsystems für Einsparungen sorgen, in die gleiche Bresche. Die Delta-Farbkompression von GP104 versucht sich an 2:1-Einsparungen – und dieser Modus soll angeblich dahingehend verbessert worden sein, dass er öfter genutzt werden kann.

Es gibt außerdem einen neuen 4:1-Modus, der dann zum Tragen kommt, wenn die Pro-Pixel-Unterschiede sehr gering sind und in einen noch kleineren Raum komprimiert werden können. Schließlich hat Pascal sogar einen 8:1-Modus, der die konstante 4:1-Kompression von 2×2-Blöcken mit einer 2:1-Kompression ihrer Unterschiede kombiniert.

|

|

|

Um das Ganze mal zu illustrieren: Das erste Bild zeigt einen nicht komprimierten Screenshot von Project CARS. Der nächste Screenshot zeigt Elemente, die Maxwell komprimieren konnte – hier durch Magenta ersetzt. Zuletzt sehen wir die Kompression durch Pascal, die noch größere Bildbereiche umfasst. Laut Nvidia resultiert das in einer etwa 20-prozentigen Reduktion der Bytes, die pro Bild aus dem Speicher abgerufen werden müssen.

- 1 - Gestatten: Nvidias GP104-GPU

- 2 - Äußerer Aufbau, Platine und Schaltungsdetails

- 3 - Simultaneous Multi-Projection und Async Compute

- 4 - Display-Pipeline, SLI und Boost 3.0

- 5 - So testen wir Nvidias GeForce GTX 1080

- 6 - Benchmarks: Ashes, Battlefield und GTA V

- 7 - Benchmarks: Hitman, CARS und Rise of the Tomb Raider

- 8 - Benchmarks: The Division und The Witcher 3

- 9 - Workstation-Performance

- 10 - Leistungsaufnahme im Detail

- 11 - Temperaturen und Lautstärke

- 12 - Fazit

Kommentieren