What does dynamic pSLC cache actually mean?

Let’s now move on to a somewhat more technical detail that most people are probably not fully aware of. A lot has already been written about pSLC cache, so there’s no need to go through it again in detail, at most as a little refresher. Here we go..

To increase the write speed, the so-called “pseudo-SLC cache” (pSLC) is often used in consumer products, although it can now also be found in various industrial solutions. For this purpose, part of the NAND capacity is configured as SLC memory, in which only one bit per cell is stored. Accordingly, this memory can be written and read very quickly. As it is not dedicated, i.e. not real SLC memory, it is called pseudo SLC. Such a cache can be used for all memory types that store several bits per flash cell, i.e. three bits as in the case of TLC. The pSLC cache also uses a significantly higher voltage for the one bit, which offers a certain level of security and is therefore better than Fast Page.

The use of pSLC cache offers a speed advantage, especially when the storage medium is not loaded with read or write accesses between the writing of large amounts of data. These idle times are used by the storage medium to move data from the cache to the TLC area.

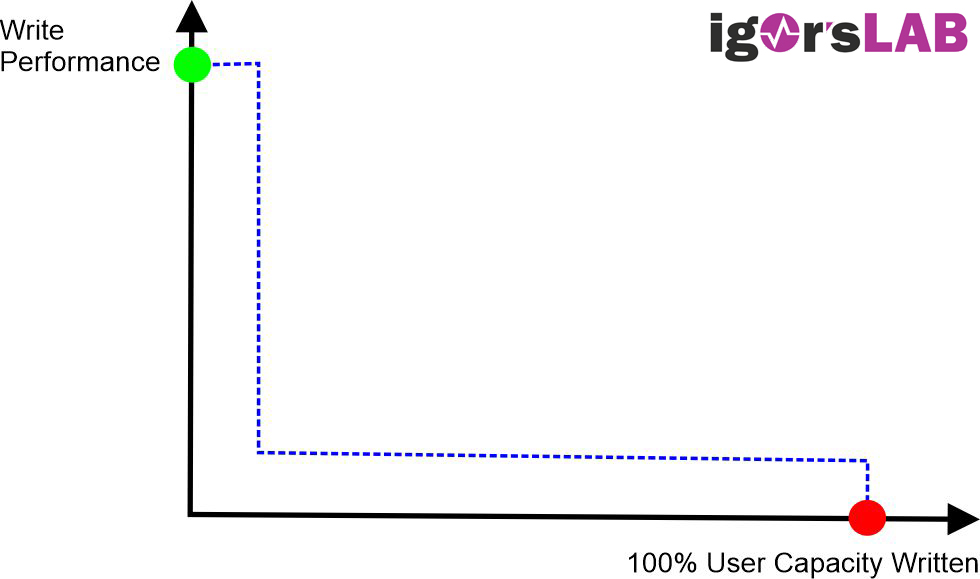

But everyone knows the disadvantages of the pSLC. When the fast pSLC cache is full, the speed drops significantly, as further write accesses to the storage medium must first free up the pSLC by moving older data from the cache to the TLC memory. But what is hidden behind “dynamic pSLC cache”?

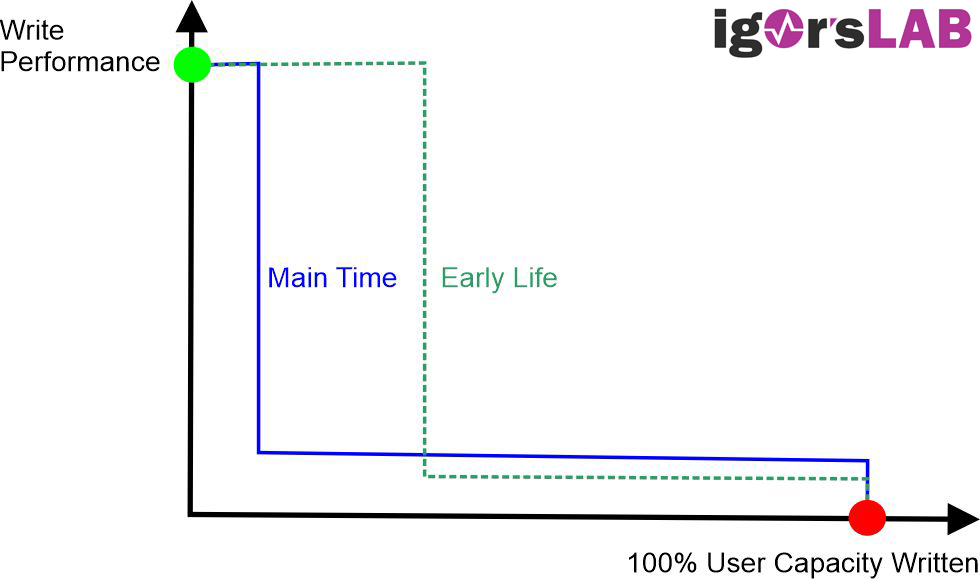

Dynamic pSLC cache has now also found its way into industrial storage solutions, but only with very severe restrictions. In contrast to the static pSLC cache, up to 100% of the NAND flash is used dynamically as a pSLC cache, depending on how full the storage medium is. The cache can therefore comprise up to 1/3 of the total memory size.

However, the write speed of the storage medium depends not only on the amount of data that is written without interruption, but also on the fill level of the memory. And this is precisely what makes the write speed in the life cycle difficult to predict.

Although NAND flash manufacturers advise against dynamically changing the configuration of flash blocks as pSLC or TLC memory for reasons of reliability, the consumer sector, where temperature windows are not so important, takes a more relaxed view.

All manufacturers of dynamic NAND storage media, including Micron, permanently switch back to TLC mode after a specified maximum number of program and erase cycles. Before this, the storage medium achieves the best values, especially for short write operations that do not require the entire capacity. After a certain period of use, however, the medium is permanently slowed down and this should never be ignored. The E26 from Phison is quite good at dynamically changing the configuration of flash blocks, but it can’t outwit physics either.

Effects in practice

In practice, the whole thing looks like this: on the empty T-FORCE Cardea Z540 2TB, the SLC cache still reaches a size of approx. 210 GB, while it is then reduced to a third on the drive that is 75% full. In both cases, the data rates then collapse when writing, but this is always the case and nothing new.

23 Antworten

Kommentar

Lade neue Kommentare

Urgestein

Mitglied

Mitglied

Mitglied

Mitglied

Veteran

Urgestein

Mitglied

Urgestein

Veteran

Veteran

Urgestein

Urgestein

Mitglied

Urgestein

Veteran

Urgestein

Mitglied

1

Alle Kommentare lesen unter igor´sLAB Community →