Bislang war NVIDIAs H100 GPU seit ihrer Markteinführung der energieintensivste Chip für Rechenzentren, da er eine maximale Nennleistung von 700 W aufwies. Diese Situation wird sich jedoch mit der Einführung der Instinct MI300X ändern, da diese noch höhere Stromverbrauchswerte aufweisen s0ll. Die AMD Instinct MI300X GPU wird in den Fußnoten zur Präsentation mit einem Stromverbrauch von 750 W angegeben.

Im Vergleich dazu verbrauchten die Instinct MI250X GPUs, die auf der CDNA 2 GPU-Architektur basieren, zwischen 500 und 560 Watt. Dies bedeutet, dass der Energiebedarf in nur einer Generation um 34 bis 50 Prozent gestiegen ist Diese Erhöhung des Energiebedarfs ist aufgrund des Designs des Chips selbst und der gebotenen Leistung zu erwarten. Diw AMD Instinct MI300X bietet eine beeindruckende 8-fache Leistungssteigerung bei KI-Workloads im Vergleich zu seinen Vorgängern. Gleichzeitig ist der Chip 5-mal effizienter, was bedeutet, dass er die gleiche Leistung bei deutlich geringerem Energieverbrauch erbringen kann. Diese Verbesserungen wurden wahrscheinlich durch technologische Fortschritte in der Chiparchitektur, dem Einsatz besserer Materialien und der Optimierung des Stromverbrauchs erreicht. AMD hat sich darauf konzentriert, die Leistungsfähigkeit und Effizienz seiner GPU-Beschleuniger zu verbessern, um den steigenden Anforderungen im Bereich der KI-Workloads gerecht zu werden. Sagt man.

Die AMD Instinct MI300X GPU ist eine hochleistungsfähige Grafikprozessoreinheit, die voraussichtlich über 304 CDNA 3 Recheneinheiten verfügen wird. Im Vergleich dazu hatte die Vorgängerin MI250X lediglich 220 Recheneinheiten. Diese Steigerung von 38% in der Anzahl der Recheneinheiten bedeutet, dass die MI300X eine erhebliche Leistungssteigerung bieten wird. Ein weiteres beeindruckendes Merkmal der MI300X ist der HBM3-Speicher mit einer Kapazität von 192 GB. Im Vergleich dazu verfügte die MI250X über 128 GB HBM2e Speicher.

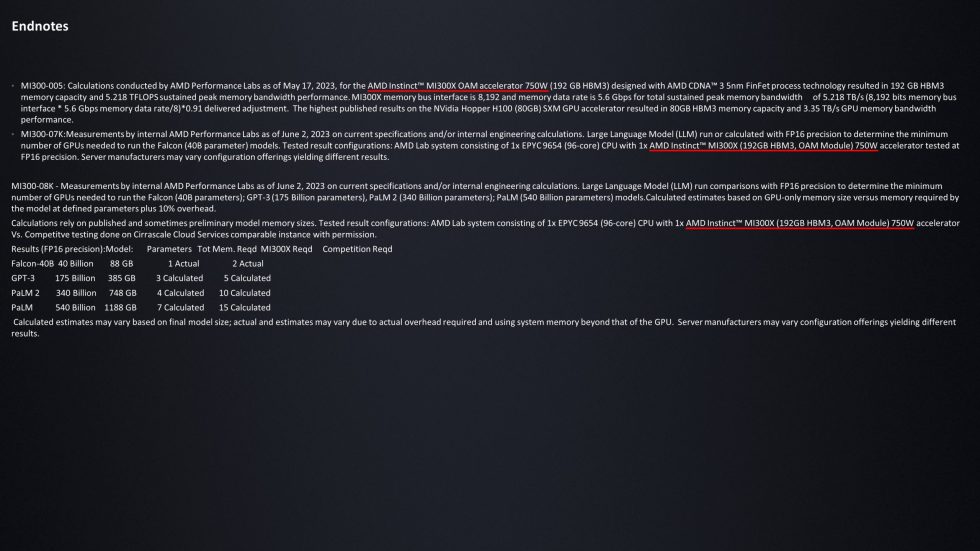

Die Kapazität des HBM3-Speichers wurde um 50% erhöht, was eine bedeutende Verbesserung darstellt. Da HBM3 eine neuere Speichertechnologie ist, werden auch viel schnellere Übertragungsgeschwindigkeiten erwartet. Ein großer Vorteil der Instinct MI300X GPU liegt im enormen 192 GB VRAM. Dies ermöglicht es, große Sprachmodelle mit weniger GPUs auszuführen als die Konkurrenz. Zum Beispiel kann die MI300X bis zu 540 Milliarden LLM-Parameter mit weniger GPUs verarbeiten als die Konkurrenzprodukte, die 80 GB H100-Chips verwenden.

Die steigenden Leistungsanforderungen in Bezug auf GPUs und HPC-Beschleuniger sind eine fortlaufende Entwicklung. Durch die zunehmende Leistungsfähigkeit dieser Komponenten wird der Bedarf an Rechenleistung kontinuierlich erhöht. Die erwähnte Gigabyte-Server-Roadmap deutet darauf hin, dass CPUs, GPUs und APUs sich der Grenze von 1000 Watt annähern. Insbesondere AMD hat in verschiedene Chip- und Verpackungstechnologien investiert, um den Stromverbrauch erheblich zu reduzieren.

Obwohl AMD als das Unternehmen mit dem stromhungrigsten Chip bekannt ist, haben sie dennoch Technologien entwickelt, um den Energiebedarf zu senken. Auf der ISSCC (International Solid-State Circuits Conference) im Jahr 2023 äußerte sich Dr. Lisa Su, CEO von AMD, zur Energieeffizienz im Bereich des Zettascale-Computings. Sie erklärte, dass ohne neue Designs ein Kernreaktor erforderlich wäre, um den Energiebedarf für ein solches System zu decken. Dies unterstreicht die zunehmende Herausforderung, mit der Unternehmen konfrontiert sind, um die steigenden Leistungsanforderungen zu erfüllen. Um diesem Bedarf gerecht zu werden, wird AMD voraussichtlich die MI300X GPUs auf den Markt bringen. Diese GPUs werden auch in konservativeren Varianten mit niedrigerem Stromverbrauch erhältlich sein, insbesondere im PCIe-Formfaktor. Obwohl die genauen Details noch nicht bekannt gegeben wurden, ist es wahrscheinlich, dass diese Varianten bis 2024 erhältlich sein werden.

Quelle: WccfTech

16 Antworten

Kommentar

Lade neue Kommentare

Urgestein

1

Urgestein

Mitglied

Urgestein

Urgestein

Urgestein

Veteran

Veteran

Veteran

Mitglied

Urgestein

Urgestein

Urgestein

Mitglied

Urgestein

Alle Kommentare lesen unter igor´sLAB Community →