Lastspitzen und Kappung

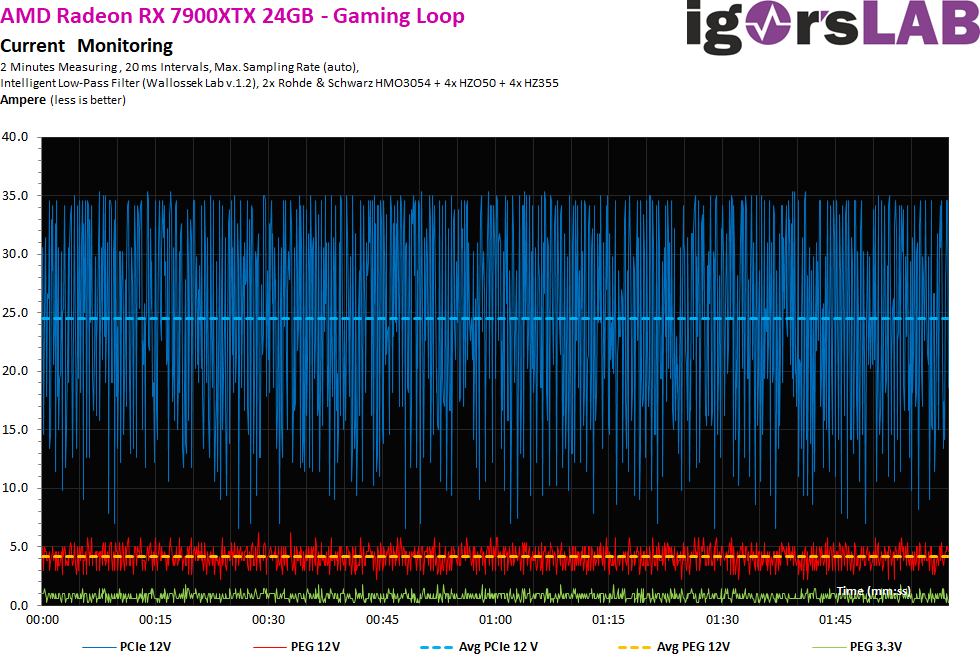

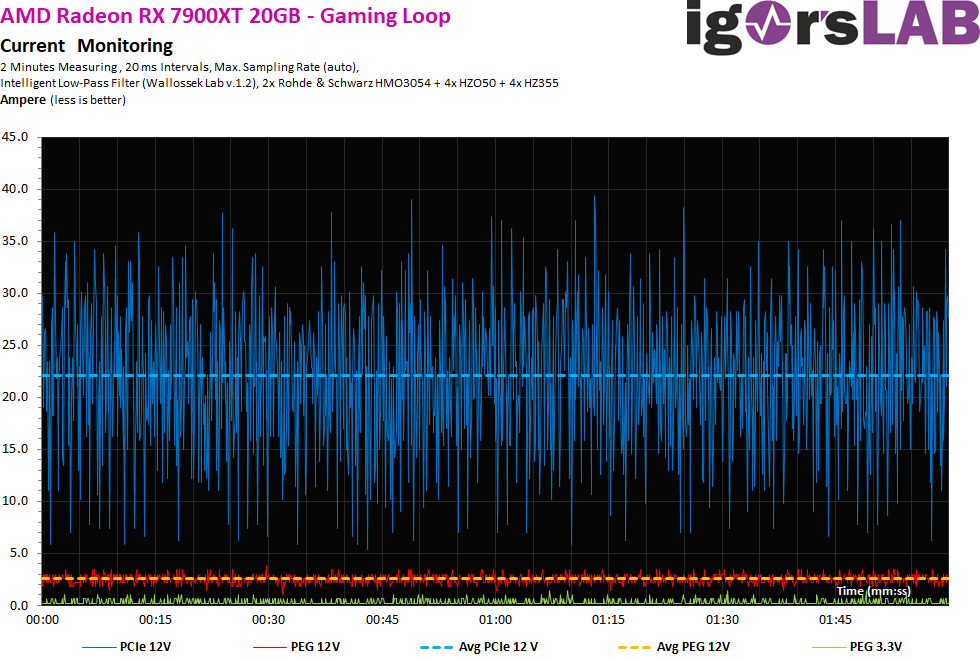

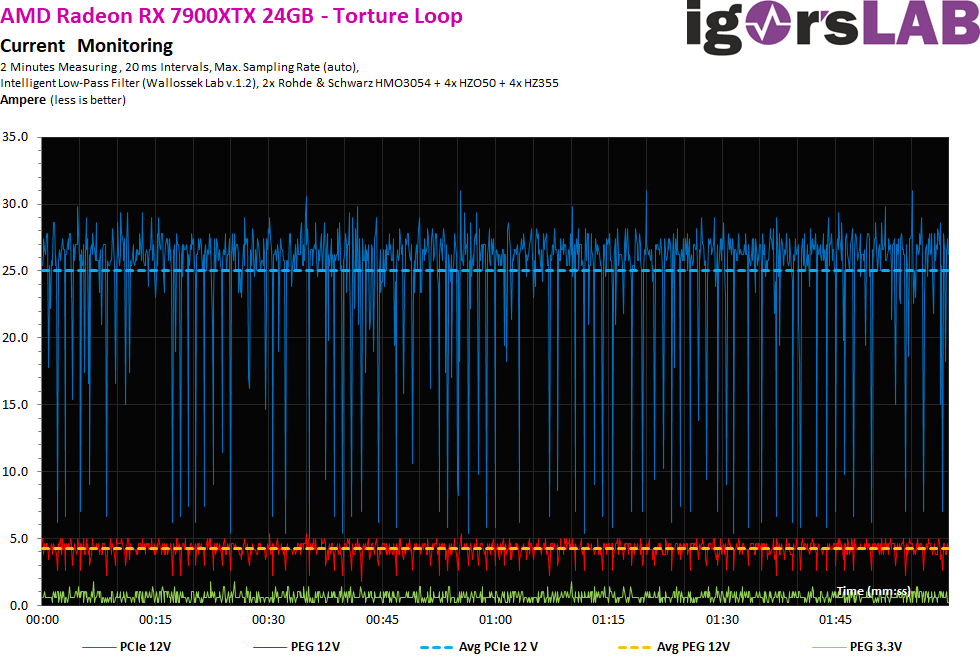

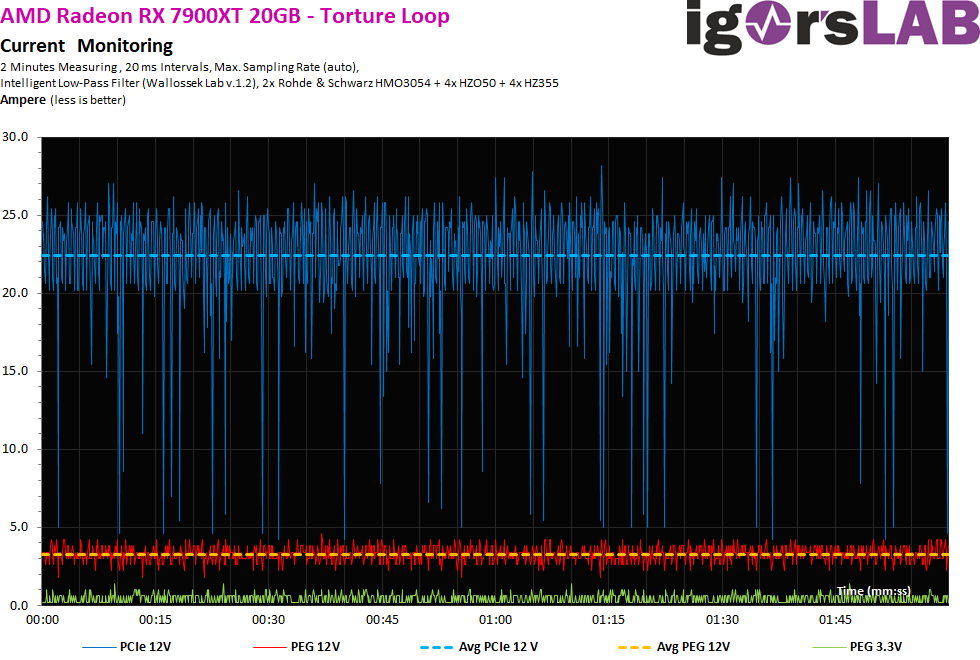

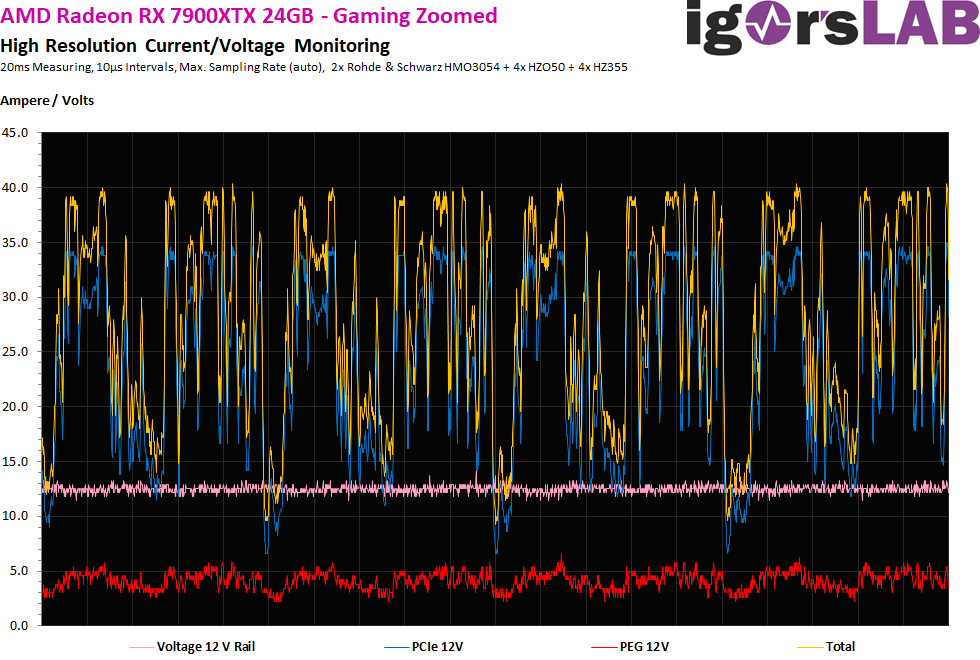

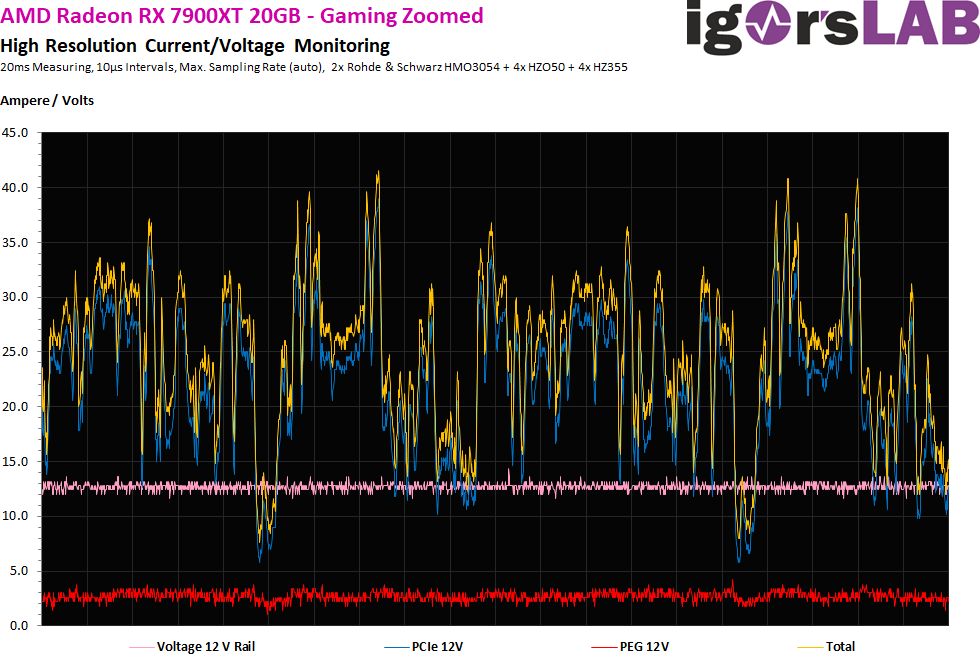

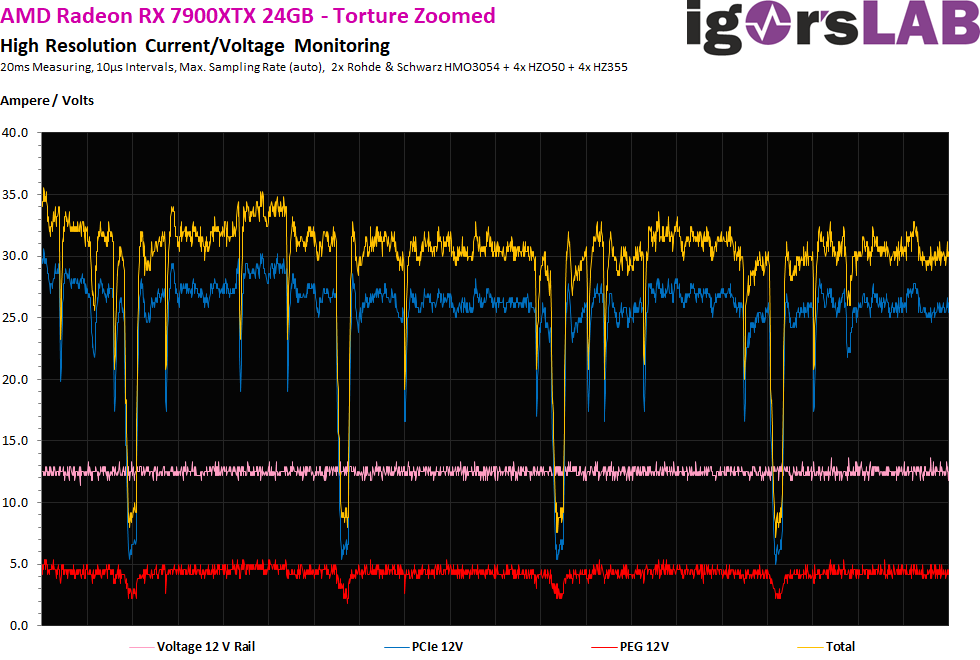

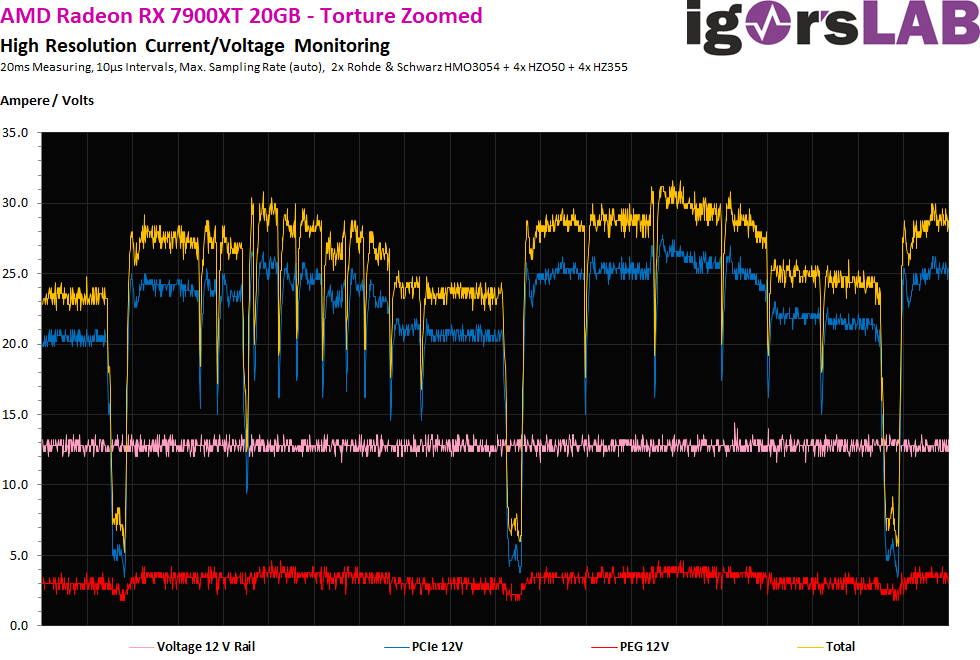

Schauen wir uns zunächst einmal die fließenden Ströme an. Gemessen wurde in gröberen 20-ms-Intervallen, also rund 50 Mal pro Sekunde, um die Last am Supervisor-Chip der Netzteile zu simulieren (Abschaltung). Wir sehen, dass ALLE Lastspitzen bei spätestens 35 A abgekappt werden. Die kleinere RX 7900XT arbeitet weniger restriktiv und erzeugt stellenweise sogar höhere Peaks bis 39 Ampere!

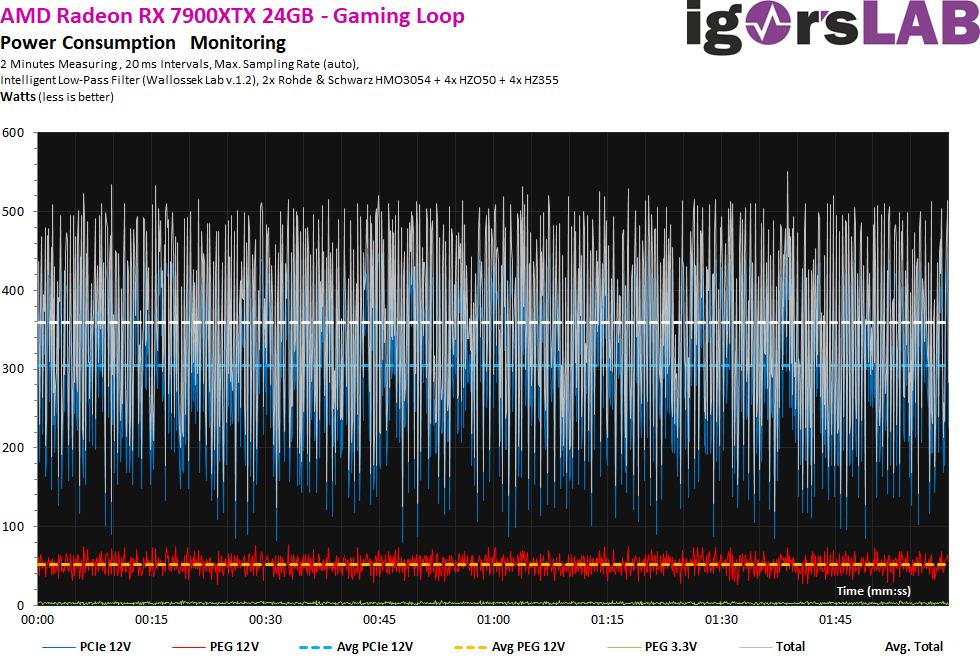

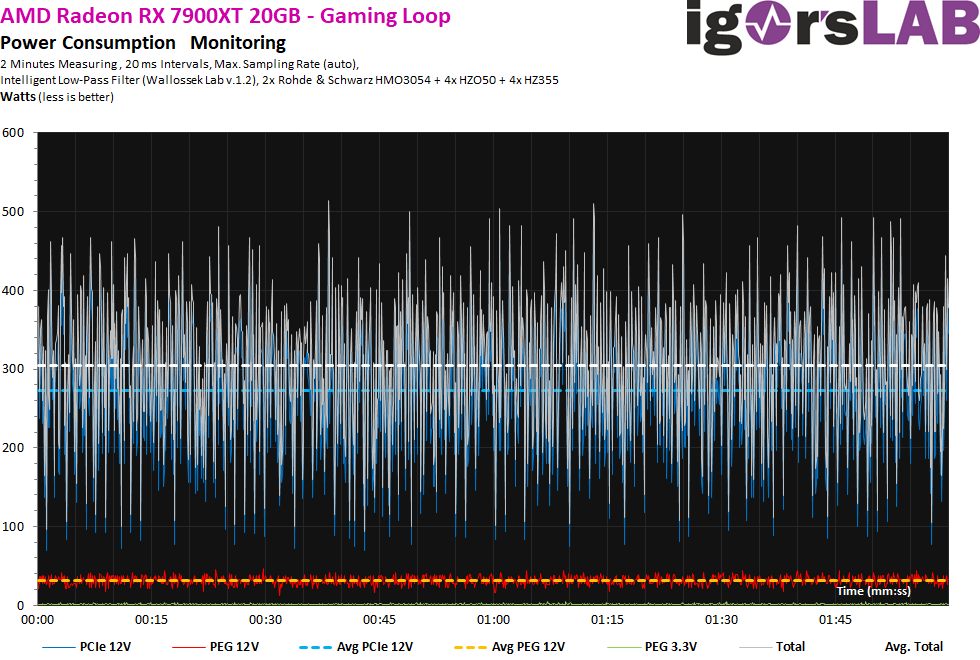

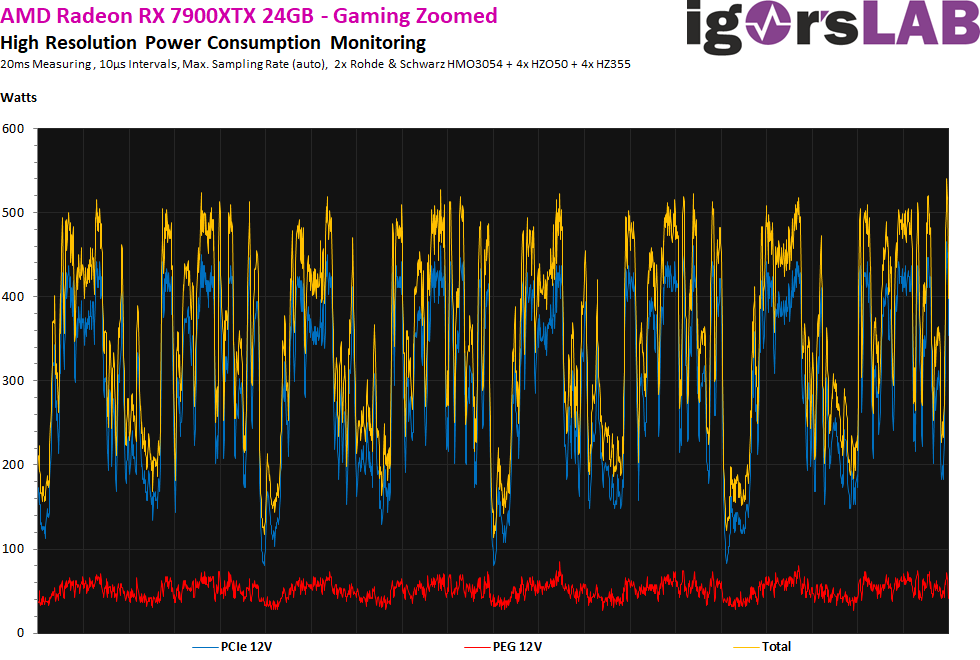

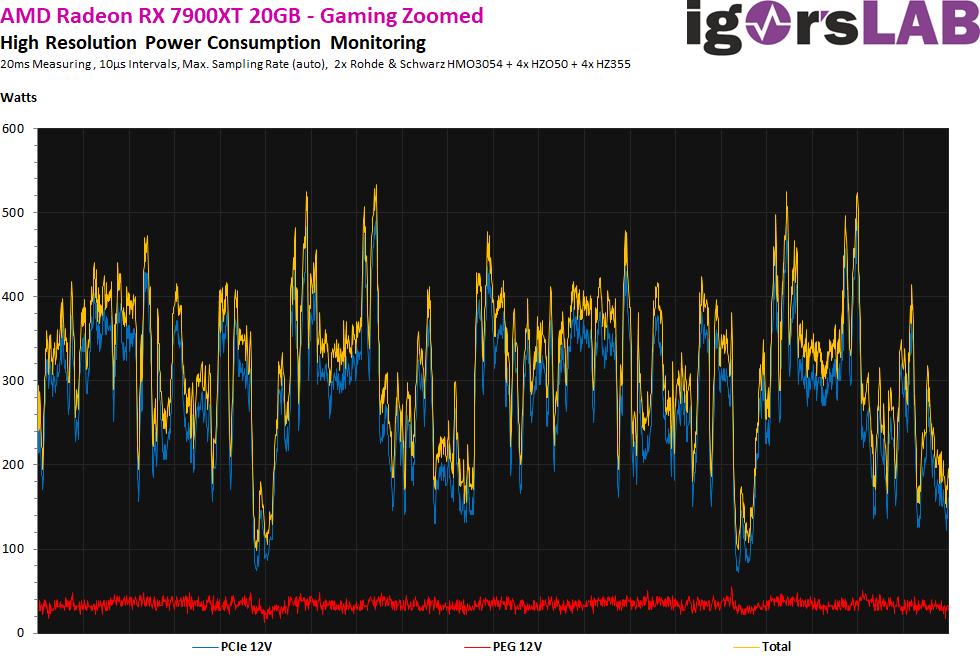

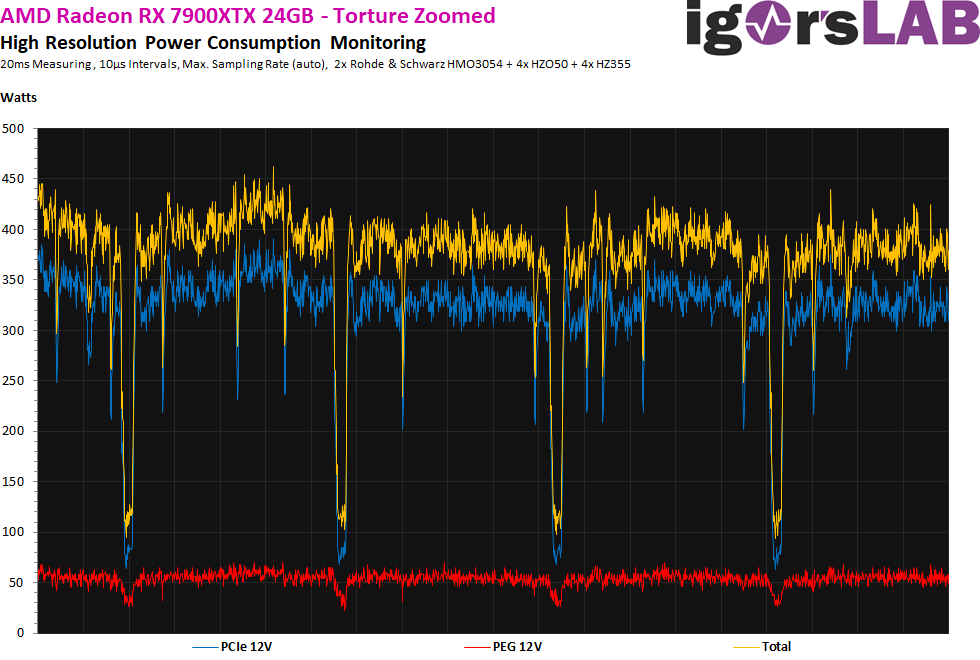

Trotzdem müssen wir noch einen Blick auf die Spannungen werfen, bzw. das Produkt aus Spannung und Stromfluss. Ich schrieb ja bereits, dass ich hier an drei verschiedenen Netzteilanschlüssen gemessen habe, auch wenn sich am Ende auf der Platine der Grafikkarte alle drei Anschlüsse wieder irgendwie treffen. Das, was wir hier jetzt als viel deutlichere Schwankungen und Spitzen erkennen können, liegt am partiell ein klein wenig übervoltenden Netzteil und somit an der Spannung und nicht den Strömen. Das ist technisch bedingt, jedoch kein Beinbruch. Wir sehen jedoch auch, dass die wenigen Spitze bei über 500 Watt nicht durch den fließenden Strom bedingt ist (Grafikkarte), sondern eigentlich vom Netzteil her resultiert! Das liegt auch an der Topologie und vor allem den Eingangsfiltern. Ich vermute, dass AMD hier mit einer etwas höheren Schaltfrequenz der Spannungsregler als NVIDIA arbeitet, was auch den zusätzlichen Frequenzmüll erklären könnte.

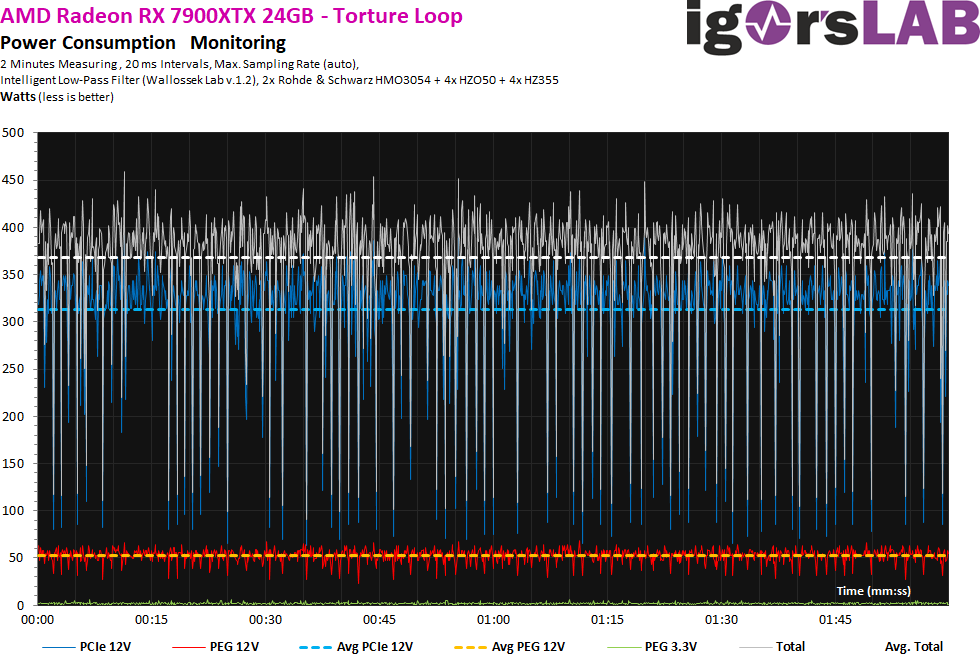

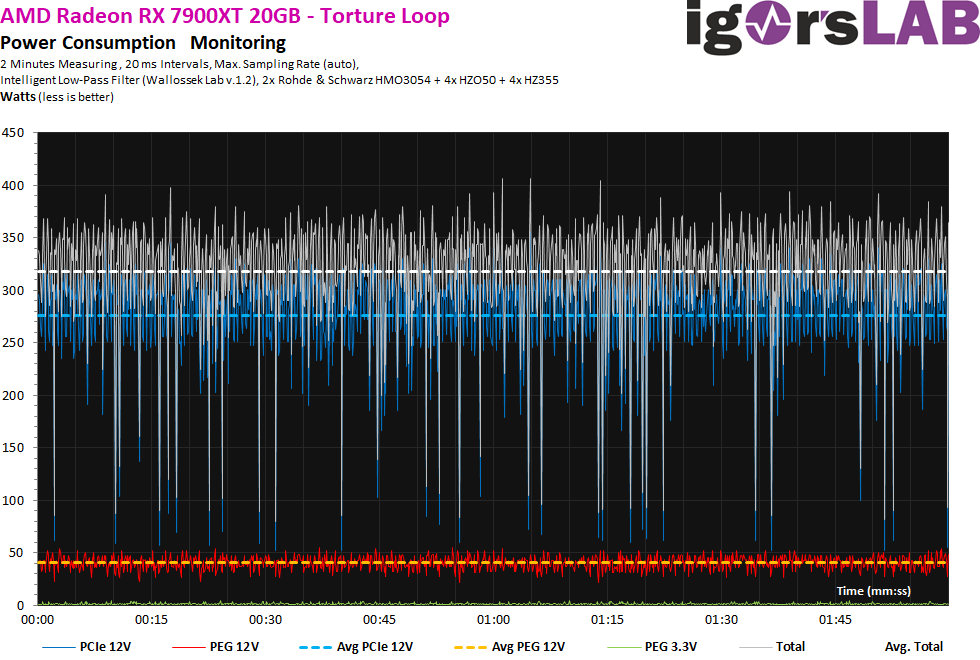

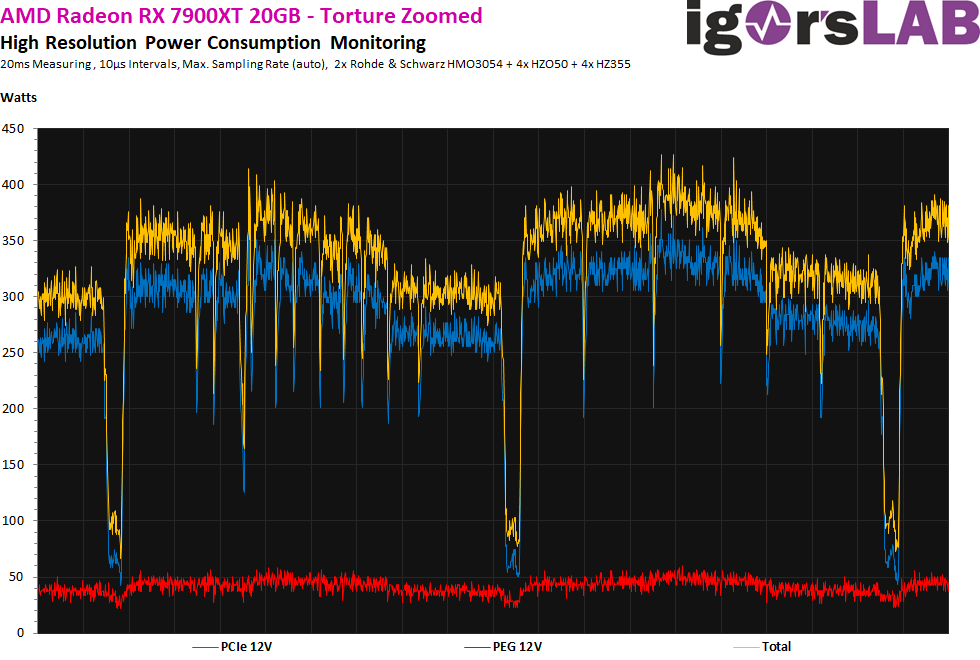

Beim Torture-Test sieht es kaum anders auch, auch wenn man hier die niedrigere TBP der RX 7900XT sieht. Doch die einzelnen Spannungsspitzen sehen eher uncool aus, übrigens bei beiden Karten.

Nimmt man jetzt wieder die Spannung mit hinzu, dann sieht man eine stärkere Welligkeit (Ripple), die sich wiederum aus der etwas hibbeligen Betriebsspannung ergibt. Allerdings muss man zur Ehrenrettung des Netzteils auch sagen, dass dies alle aktuellen Produkte aller Hersteller betrifft und sicher auch kaum zu vermeiden ist.

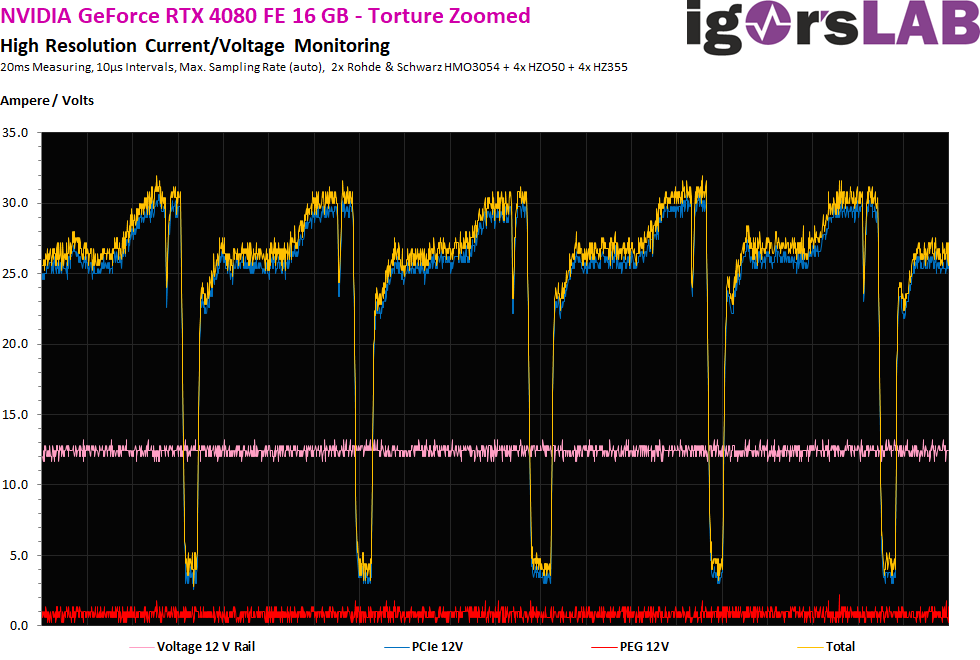

Weil ich es aber noch ganz genau wissen möchte, löse ich das Ganze einmal noch höher auf und nehme mir 20 ms als gesamte Laufzeit vor. Die Intervalle von 10 Mikrosekunden sind gerade noch sinnvoll messbar und wir sehen hier als graue Kurve auch einmal die Spannung, deren Mittelwert zwar bei knapp über 12 Volt liegt, die aber nichtsdestotrotz im Rahmen des Zulässigen noch etwas alterniert. Die beiden Radeons schalten deutlich öfter als die RTX 4080 und RTX 4090, während man nur beider 7900XTX eine echte Kappung bei rund 40 Ampere sehen kann. Bei der RX 7900XT geht das partiell sogar deutlich höher.

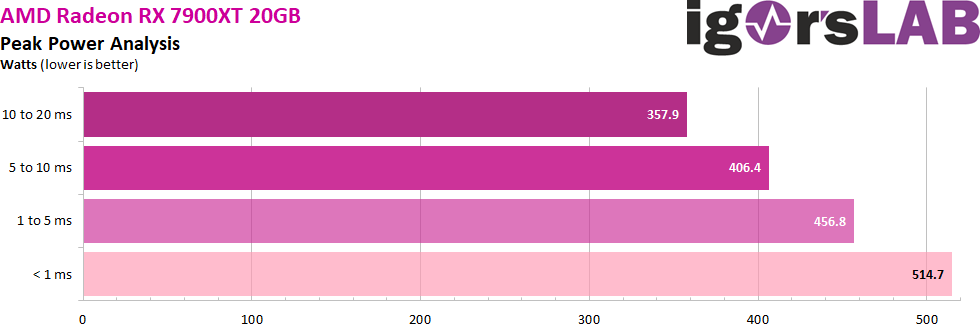

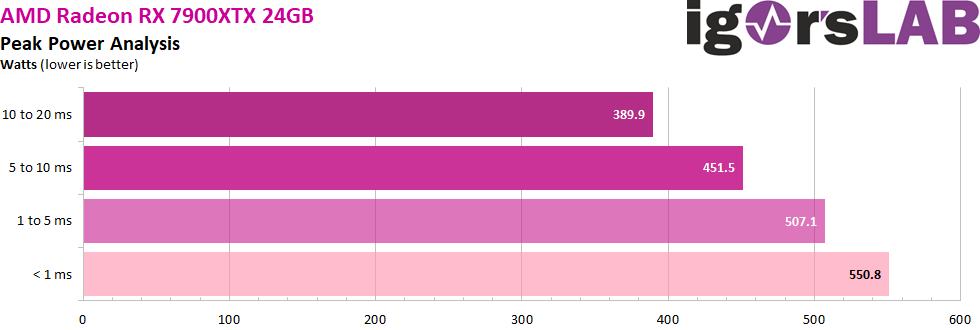

Rechnet man das dann auf die Leistungsaufnahme in Watt um, dann erhält man dieses Bild:

Das Ganze habe ich auch noch einmal für den Torture-Loop gemacht, bei dem wir die regelmäßigen Drops bewundern dürfen. Zunächst wieder die Ströme, die aber in jedem Anstieg noch jede Menge eigenartiger, sporadisch wiederkehrender Drops aufweisen. Das sieht aus wie ein heftiger Schluckauf, bevor die Leistung kurz darauf wieder richtig gedrosselt wird.

Hier mal zu Vergleich die GeForce RTX 4080, die ein deutlich besseres Last-Management aufweist:

Und dann wieder gesamte Watt-Zahl:

Netzteilempfehlung

Kommen wir nun zu dem Punkt, der die erwartete Sensation explodierender Netzteile komplett ad absurdum führt. Selbst WENN man die Karte hoffnungslos überpowert, braucht eigentlich kein Mensch ATX 3.0 Netzteile über 1000 Watt, es sei denn, die CPU frisst mehr als 300 Watt. Das ist wirklich eine reine Arbeitsbeschaffungsmaßnahme für die darbende Netzteilindustrie und befriedigt nur die kranke Phantasie einiger Normierungs-Fetischisten. Das muss man wirklich mal so hart formulieren. Man sollte also auch zusammen mit der CPU immer unter 600 bis 700 Watt bleiben, wenn man bis 10 ms mitrechnet. Denn es ist das, was die Netzteile noch “sehen”

Dahingehend formuliere ich auch meine Netzteilempfehlung, die bei beiden Modellen so lautet, dass man mit einem modernen 650-Watt Gold- oder Platin-Netzteil recht sicher hinkommen sollte. Wer übertakten möchte, sollte noch einmal 100 Watt mehr einplanen, was vor allem auch für die Boardpartner-Karten gilt.

| be quiet! |

Straight Power 11 650 Watt Gold |

| Sharkoon |

Silent Storm Cool Zero 650 Watt |

| Corsair |

RM 650 Gold 650 Watt |

- 1 - Einführung, technische Daten und Technologie

- 2 - Test System im igor'sLAB MIFCOM-PC

- 3 - Teardown: PCB und Komponenten

- 4 - Teardown: Kühler und De-Montage-Tips

- 5 - Summe Gaming-Performance WQHD (2560 x 1440)

- 6 - Summe Gaming-Performance Ultra-HD (3840 x 2160)

- 7 - Einzelmetriken für WQHD (2560 x 1440)

- 8 - Einzelmetriken für Ultra-HD (3840 x 2160)

- 9 - Workstation Grafik und Rendering

- 10 - Details: Leistungsaufnahme und Lastverteilung

- 11 - Lastspitzen, Kappung und Netzteilempfehlung

- 12 - Temperaturen, Taktraten und Infrarot-Analyse

- 13 - Lüfterkurven und Lautstärke

- 14 - Zusammenfassung und Fazit

892 Antworten

Kommentar

Lade neue Kommentare

Mitglied

1

Urgestein

Urgestein

Mitglied

Mitglied

Neuling

Urgestein

Veteran

Urgestein

Neuling

Urgestein

1

Urgestein

Veteran

Mitglied

Mitglied

Urgestein

Mitglied

Alle Kommentare lesen unter igor´sLAB Community →